PUBLICATIONS

GCSnews 28/2020 (Juni 2020)

GCS-Rechner für Corona-Forschung

Seit dem 16. März stellt das GCS in einem Eilverfahren Rechenkapazitäten seiner Höchstleistungsrechner Hawk am HLRS, JUWELS am JSC und SuperMUC-NG am LRZ für Covid-19-Forschung zur Verfügung. Alle Anträge für Rechenzeitkontingente, die der Erforschung des Corona-Virus, seiner Prävention, Eindämmung, oder der Impfstoffentwicklung dienen, werden im Zuge eines dezidiert eingerichteten Schnellbegutachtungs-Verfahrens geprüft und bei positiver Validierung ohne Verzögerung genehmigt. Zur Unterstützung der Covid-19-Forschungsvorhaben von außerhalb der nationalen Grenzen angesiedelten Wissenschaftlern bietet das GCS zudem der internationalen Wissenschaftsgemeinde Rechenkapazitäten auf seinen drei High-Performance Computing (HPC) Systemen über seinen europäischen Partner PRACE (Partnership for Advanced Computing in Europe) an, der in einem ähnlichen Eilverfahren Rechenkapazitäten für Covid-19-Forschung auf europäischen HPC-Systemen zuweist. Zum Zeitpunkt 20.06.2020 sind an den drei GCS-Zentren HLRS, JSC und LRZ insgesamt 21 Covid-19-Forschungsprojekte aktiv. Die komplette Liste der durchgeführten Covid-19 Forschungsvorhabenist auf der GCS-Website einsehbar.

GCS auf der Internationalen Supercomputing Conference 2020

Die Internationale Supercomputing Conference (ISC) fand in diesem Jahr aufgrund der Covid-19-Pandemie in digitaler Form vom 22. bis 25. Juni statt. Die angebotenen Vorträge sind auf der ISC-Website bis zum 6. Juli 2020 exklusiv für registrierte Teilnehmende verfügbar, danach für jedermann einsehbar. Sie konzentrieren sich auf die neuesten internationalen Entwicklungen und Trends in den Bereichen Hoch- und Höchstleistungsrechnen, maschinelles Lernen und Datenanalyse. Auch für die ISC2020 Digital, für die Prof. Dr. Martin Schulz, Mitglied des Direktoriums des Leibniz-Rechenzentrums, Garching, und Professor an der Technischen Universität München, als stellvertretender Vorsitzender des wissenschaftlichen Programms agierte, hatten das GCS und Vertreter der drei GCS-Zentren mit diversen Beiträgen zum Gelingen der Veranstaltung beigetragen. (Weitere Informationen)

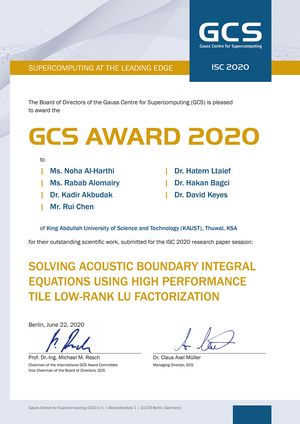

GCS-Award 2020 geht an Wissenschaftler*innen aus Saudi-Arabien

Zum bereits 10. Mal vergab das GCS den jährlich auf der Internationalen Supercomputing Conference (ISC) verliehenen GCSAward, mit dem das beste auf der Konferenz eingereichte, technische Paper aus dem Bereich des High-Performance Computing (HPC) gekürt wird. In diesem Jahr ging die Trophäe, die mit einem Preisgeld von 5.000 € verbunden ist, an ein siebenköpfiges Team von Wissenschaftler*innen des Extreme Computing Research Centers (ECRC) an der King Abdullah University of Science and Technology (KAUST) in Saudi-Arabien. Ihr Paper mit dem Titel „Solving Acoustic Boundary Integral Equations Using High Performance Tile Low-Rank LU Factorization“, das das GCS-Award-Komitee in seinem formellen, anonymen Begutachterverfahren („double blind review process“) als wertvollsten Beitrag identifizierte, widmet sich einem in der Welt des Höchstleistungsrechnens (HPC) immer wichtiger werdenden Thema: der Optimierung von HPC-Anwendungen zur höchstmöglichen und optimalen Ausnutzung des verfügbaren Hauptspeichers der HPC-Systeme. Da die ISC2020 aus gegebenem Anlass in digitaler Form stattfand, wurde der GCS-Award ebenfalls im Zuge einer „virtuellen Übergabezeremonie“ (per e-mail) den beiden Hauptautorinnen des Papers, Ms. Noha Al-Harthi und Ms. Rabab Alomairy, überreicht. Weitere Informationen

GCS sponsert 3 Studentencluster-Teams der ISC2020 Digital

Das GCS führt sein Engagement fort, junge Talente aus den MINT-Studiengängen für das High-Performance Computing (HPC) zu begeistern. Auch in diesem Jahr sponsert das GCS Studententeams der Friedrich-Alexander-Universität Erlangen-Nürnberg, der Universität Hamburg und der Universität Heidelberg, die sich für den Studentenclusterwettbewerb (SCC) der ISC2020 qualifizieren konnten. Wie die ISC selbst wurde dieser Wettbewerb, der seit Langem fester Bestandteil der ISC ist, aufgrund der Corona-Krise in digitaler Form ausgetragen, erstreckte sich über den Zeitraum von drei Wochen (1.-24. Juni) und stand im Zeichen des Kampfs gegen Covid-19. Die insgesamt 14 Studententeams aus aller Welt waren beauftragt, verschiedene Anwendungen zu testen, die derzeit von Wissenschaftler*innen und Forschenden auf der Suche nach einem Heilmittel gegen Covid-19 genutzt werden. Das GCS unterstützte die Teams mit einem finanziellen Zuschuss zur Deckung wettkampfbedingter Auslagen und bot darüber hinaus in der Vorbereitungsphase Training und Support der Studenten durch HPC-Experten der drei GCS-Zentren HLRS, JSC und LRZ an. Weitere Informationen

Hackerangriff auf GCS-Supercomputer

Mitte Mai mussten die GCS-Höchstleistungsrechner Hawk am HLRS, JUWELS am JSC und SuperMUC-NG am LRZ, wie zahlreiche andere Forschungsrechner in Deutschland und Europa auch, wegen eines IT-Sicherheitsvorfalls vorübergehend vom Netz genommen werden. Hacker hatten sich Zugang zu den Systemen verschaffen können. Um weiteren Schaden abwenden zu können, wurde der Nutzerbetrieb auf den betroffenen HPC-Systemen eingestellt, weshalb die wertvollen Computing-Ressourcen des GCS der Wissenschaftsgemeinde für einige Wochen nicht zur Verfügung standen. Aktuell werden die drei GCS-Supercomputer nach und nach kontrolliert hochgefahren, Nutzer der Rechner müssen wegen der vorerst restriktiven und innerhalb der nationalen Gemeinschaft abgestimmten Sicherheitskonzepte allerdings noch mit Einschränkungen rechnen. Wer für den Angriff verantwortlich ist, wird derzeit untersucht – die zuständigen Sicherheitsbehörden ermitteln.

2,3 Mrd. Kernstunden Rechenzeit für nationale Forschungs-Großprojekte

Insgesamt 20 nationale Forschungsvorhaben erhielten im April d.J. den Bescheid, dass ihre Anträge auf Rechenzeit-Großkontingente im Rahmen des 23. GCS Call for Large-Scale Projects positiv begutachtet wurden. Die GCS-Rechenzeitkommission teilte diesen Vorhaben in Summe 2,3 Milliarden Kernstunden auf den HPC-Systemen der drei GCS-Zentren HLRS, JSC und LRZ zu. Die unterstützten Simulationsprojekte kommen aus fast allen Bereichen der Wissenschaft, wie z. B. der Astrophysik, Nuklear-, Elementarteilchen- und Festkörperphysik, der Geologie, der Bio-Informatik und theoretischen Biologie sowie den Ingenieurwissenschaften. Die größten individuellen Rechenzeitzuwendungen des aktuellen Calls wurden zwei Anträgen aus dem Bereich der Strömungsmechanik zuteil: Für die Projekte „Noise Reduction by Porous Material, Base-Flow Fields of Space Launchers and Transonic Buffet on Commercial Aircraft Wings“ (Leitung: Dr. Matthias Meinke, Aerodynamisches Institut (AIA), RWTH Aachen University) und „LAMTUR - Investigation of Laminar-Turbulent Transition and Flow Control in Boundary Layers“ (Leitung: Dr.-Ing. Markus J. Kloker, Institut für Aerodynamik und Gas Dynamik (IAG), Universität Stuttgart) wurden jeweils 500 Millionen Kernstunden auf dem neuen HLRS-Höchstleistungsrechner Hawk genehmigt. Für den JSC-Supercomputer JUWELS gingen die größten Rechenzeitzuweisungen an zwei Projekte aus dem Bereich der Elementarteilchenphysik (Leitung: Prof. Dr. Ulf-G. Meißner, Universität Bonn, bzw. Prof. Dr. Harvey B. Meyer, Johannes-Gutenberg-Universität Mainz), während für den LRZ-Höchstleistungsrechner SuperMUC-NG die beiden größten Projekte des aktuellen Calls aus dem Bereich der Astrophysik kommen (Leitung: Dr. Klaus Dolag, Fakultät für Physik, Ludwig-Maximilians-Universität München bzw. Prof. Dr. Fakher Assaad, Institut für Theoretische Physik und Astrophysik, Universität Würzburg). Den Wissenschaftlern stehen die GCS-HPC-Ressourcen für die Projekte aus dem aktuellen Call bis Ende April 2021 zur Verfügung. (Genehmigte Projekte)

QuantEx: Wie simuliert man einen Quantencomputer?

Gemeinsam mit dem Irish Centre for High End Computing (ICHEC) entwickelt das LRZ Tools für die Simulation von Algorithmen des Quantencomputing. Da die bisher verfügbare Quantencomputer-Hardware noch zu klein und störungsanfällig ist, simuliert man die programmiertechnischen und mathematischen Operationen auf traditionellen Supercomputern. Diese müssen dazu äußerst leistungsfähig sein, so wie die Rechner des GCS. „Ziel ist es, Werkzeuge für die Simulation von Quantenschaltkreisen zu entwickeln“, erklärt Dr. Luigi Iapichino, Teamleiter für Quantencomputing am LRZ. „Simulationen helfen beim Schreiben und Debuggen von Programmen für Quantencomputer, ohne dass diese zur Verfügung stehen.“

HLRS leitet europäische HPC-Projekte EuroCC und CASTIEL

Das EuroHPC Joint Undertaking (JU) hat den vom Gauss Centre for Supercomputing (GCS) und dem Höchstleistungsrechenzentrum Stuttgart (HLRS) eingereichten Antrag EuroCC befürwortet. Unter federführender Leitung des HLRS soll im Laufe von zwei Jahren unter dem Titel EuroCC ein europaweites Netzwerk nationaler HPC-Kompetenzzentren geschaffen werden, dem sich bisher 33 europäische Staaten angeschlossen haben. Ziel des Projekts ist es, dass sich die Kompetenzzentren der teilnehmenden Länder als nationale Ankerpunkte etablieren, um das von den nationalen Experten bereitgestellte HPC-Know-How, Trainings-Ressourcen sowie HPC-Dienstleistungen und -Werkzeuge den jeweiligen Nutzergruppen ihres Heimatlandes zur Verfügung zu stellen. Im Fokus des Vorhabens steht insbesondere die Zusammenarbeit

mit der jeweiligen nationalen Industrie.

Parallel hierzu wurde dem GCS und dem HLRS die Leitung eines eng mit EuroCC einhergehenden zweiten EU-Projektes übertragen. Das Vorhaben CASTIEL, in dem mit CINECA in Italien, dem TERATEC-Konsortium, dem Barcelona Supercomputing Center und PRACE (Partnership for Advanced Computing in Europe) weitere Europäische HPC-Institutionen mitwirken, hat zum Ziel, die Weitergabe der im Rahmen des EuroCC-Vorhabens erworbenen Kenntnisse und Expertise über die jeweiligen Landesgrenzen hinweg zu koordinieren. Während es die Rolle von EuroCC ist, die HPC-Expertise innerhalb der einzelnen Mitgliedsstaaten zu entwickeln und zu fördern, wird es die Aufgabe von CASTIEL sein, diese Expertise über das gesamte EuroCC-Netzwerk hinweg verfügbar zu machen. Dies soll durch internationale Workshops, Mentoring-Programme und dezidierte Partnerschaften, sowie themenspezifische Arbeitsgruppen erreicht werden, im Rahmen derer gemeinsame Themenpunkte identifiziert und gezielt angegangen werden können. Die Projektverantwortlichen erwarten, dass diese beiden EU-weiten Projekte das HPC-Niveau auf gesamteuropäischer Ebene steigern, während sie zugleich neue Synergien erzeugen und neue Partnerschaften über Landesgrenzen hinweg ermöglichen. Offizieller Starttermin für EuroCC und CASTIEL ist der 1. September 2020. (Weitere Informationen)

Neues NIC-Exzellenzprojekt am JSC

Zweimal im Jahr vergibt die NIC-Rechenzeitkommission den Titel „NIC-Exzellenzprojekt“ an herausragende Simulationsprojekte. Im April zeichnete die Kommission das Projekt „Nukleare Gittersimulationen“ von Prof. Ulf-G. Meißner (Institut für Kernphysik am Forschungszentrum Jülich, Helmholtz-Institut für Strahlen- und Kernphysik an der Universität Bonn) aus. Ziel des Projektes ist es, ein tieferes Verständnis der vielen bemerkenswerten Phänomene in der Kernphysik zu erlangen. Hierunter fallen die Elemententstehung in Sternen, die Grenzen der Stabilität von Atomkernen, das Auftreten von Unterstrukturen („alpha-clustering“) oder die Thermodynamik von heißer und dichter Kernmaterie und die Berechnung der dazugehörenden Zustandsgleichung. Die zugrundeliegenden Simulationen werden begleitet von der Entwicklung

immer besserer Algorithmen, so dass es zum Beispiel möglich ist, Reaktionen wie die Erzeugung von Sauerstoff-Kernen in Sternen durch Einfang eines Alpha-Teilchens am Kohlenstoff ohne jegliche Näherung auszurechnen. Von besonderem Interesse sind zurzeit die detaillierten Untersuchungen des Gas-Flüssigkeits-Übergangs im Phasendiagramm der stark wechselwirkenden Materie und die präzise Berechnung der Eigenschaften von Atomkernen bis in die Region mittlerer Massen (A<60). (Weitere Informationen)

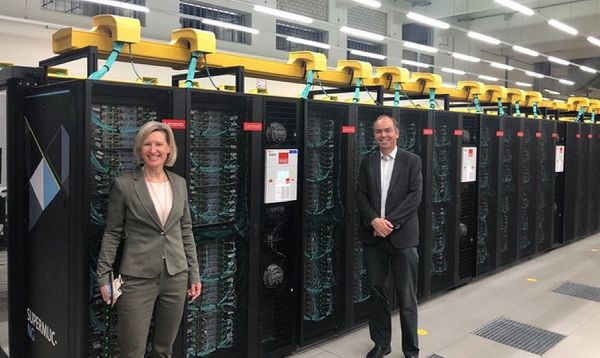

EU-Parlamentarierin und Quantencomputing-Pionier besuchen das LRZ

Prof. Dr. Angelika Niebler, Abgeordnete im Europaparlament, besuchte am 19. Mai 2020 das LRZ, um sich den Höchstleistungsrechner SuperMUC-NG zeigen zu lassen und sich über seine Leistungsfähigkeit zu informieren. Ein Arbeitsschwerpunkt Frau Nieblers sind die europäischen Forschungsprogramme. Sie hatte dafür beste Begleitung mitgebracht: Dr. Axel Thierauf, Chairman des 2018 gegründeten finnischen Unternehmens IQM Finland, das aus der universitären Forschung entstand und sich darauf spezialisiert hat, echte Hardware für das Quantencomputing zu entwickeln, sowohl die supraleitenden Qubits, als auch die dafür nötige extrem kalte Umgebung. Niebler und Thierauf zeigten sich begeistert von den Möglichkeiten, die SuperMUC-NG, ein „klassischer“ Rechner bietet, um schon heute das Quantencomputing voranzubringen. (Weitere Informationen)

Booster-Modul ergänzt DEEP-EST-Prototypsystem

Das Prototypsystem des DEEP-EST-Projekts ist jetzt komplett: Mitte Mai wurde das letzte Modul - das Extreme Scale Booster-Modul (ESB) - im JSC installiert. Basierend auf der im JSC entwickelten modularen Supercomputing-Architektur besteht der DEEP-EST-Prototyp nun aus drei Rechenmodulen: ein Cluster-Modul, ein spezielles Modul für Data Analytics und dem neuen Booster-Modul. Die beiden ersten Module, die bereits 2019 am JSC installiert wurden, sind für Anwendungen mit niedrigerer Parallelität und die Verwaltung großer Datenmengen ausgelegt. Der energieeffiziente Booster bietet nun zusätzlich 75 Knoten, um den Anforderungen hochskalierbarer, paralleler Codes gerecht zu werden und sie an die Computerarchitekturen anzupassen, die voraussichtlich in der Exascale-Ära zum Einsatz kommen werden. Das vom Projektpartner MEGWARE integrierte DEEP-EST-Komplettsystem verfügt über modernste Hochleistungstechnologien und nutzt auch die innovative MEGWARE-Technologie der direkten Flüssigkeitskühlung mit Warmwasser für hohe Energieeffizienz. Der DEEP-EST-Prototyp steht den Projektpartnern und über das Early-Access-Programm auch externen Nutzern zur Verfügung. (Technische Einzelheiten zum System)

HLRS: Entwicklung ethischer Standards für KI

Das HLRS ist eine der treibenden Kräfte der neugegründeten Arbeitsgruppe „AI Ethics Impact“ (AIEI) Group, die sich der ethischen Normierung von Künstlicher Intelligenz (KI) widmet. KI-Anwendungen werden zunehmend in Entscheidungskontexten eingesetzt: Welcher Bewerber auf eine Stelle soll eingestellt werden? Woran ist eine Person erkrankt und wie kann ihr geholfen werden? Wie kann öffentliche Sicherheit geschützt werden? Beim Einsatz KI-basierter Systeme ist es deshalb wichtig, dass sie gerecht sind (keinen Bias enthalten), nachvollziehbar und verlässlich. Die Sicherstellung, dass KI-Systeme diese Anforderungen erfüllen, führt unweigerlich zu Fragen nach einem geeigneten Standardisierungsverfahren. Die AIEI Group, zu der neben dem HLRS das VDE, die Bertelsmann Stiftung, das Karlsruher Institut für Technologie (KIT) und das Internationale Zentrum für Ethik in den Wissenschaften (IZEW) gehören, hat eine neuartige Methode entwickelt, die Entwickler*innen, Anwender*innen und Betroffene gleichermaßen bei der Orientierung unterstützen: From Principles to Practice. Das interdisciplinary framework to operationalise AI ethics erläutert, wie man ethische Standards wirksam und nachprüfbar international umsetzen kann. (Weitere Informationen)

JUSUF – Neue Mehrzweck-Rechenplattform für Neurowissenschaftler am JSC

Ein neues Cluster-System namens JUSUF ist am JSC in Betrieb genommen worden. Das System der Fa. Atos ist Teil von Fenix, einer paneuropäischen föderierten e-Infrastruktur, die Rechen- und Speicherkapazität sowie Cloud-Dienste für das Human Brain Project (HBP) und andere Wissenschaftsgemeinschaften mit ähnlichen Anforderungen zur Verfügung stellt. JUSUF verfügt über 205 Knoten mit AMD EPYC Rome-Prozessoren. Besonderes Merkmal des Clusters ist ein Aufbau, der es Knoten erlaubt, entweder Teil eines HPC-Clusters oder eines OpenStack-Clusters zu sein. Dadurch ist das System in der Lage, innerhalb von Fenix flexibel verschiedene Arten von Diensten zu liefern: Skalierbare Rechenleistung, Rechenleistung mit interaktivem Zugang und virtuelle Maschinen. Die verteilte e-Infrastruktur Fenix wird von einem Konsortium bestehend aus den fünf europäischen HPC-Zentren BSC, CEA, CINECA, CSCS und JSC im Rahmen des Projekts „Interactive Computing E-Infrastructure (ICEI) for the Human Brain Project“ aufgebaut, das von der Europäischen Union gefördert wird. Fenix bildet die Grundlage von EBRAINS, einer digitalen Forschungsinfrastruktur für die Hirnforschung, das vom HBP entwickelt wird. Die Fenix-Dienste, einschließlich der JUSUF-Ressourcen, sind verfügbar für Mitglieder des HBP-Projekts (über EBRAINS), europäische Wissenschaftler aus allen Bereichen (über PRACE) und Nutzer aus Deutschland. Einzelheiten zum Zugang sind verfügbar unter https://fenix-ri.eu/access

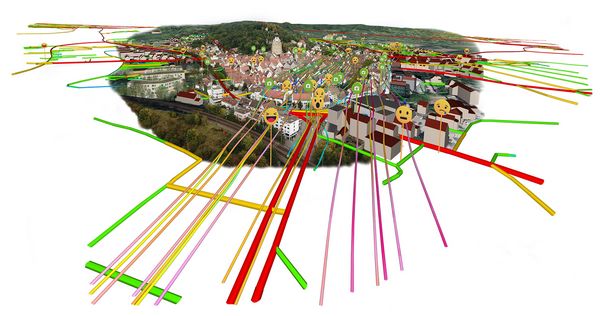

HLRS: Digitaler Zwilling für die Stadtplanung

In Kooperation mit Forschern des Fraunhofer IAO, der Universität Stuttgart und dem Kommunikationsbüro Ulmer hat ein Team des Höchstleistungsrechenzentrums Stuttgart (HLRS) neue Methoden und Tools zur Planungs- und Entscheidungsunterstützung für Städte entwickelt. Im „Digitalen Zwilling“ der Stadt Herrenberg (Baden-Württemberg) wurden mithilfe von Supercomputing-Technologien komplexe urbane Daten analysiert, simuliert, in Modelle integriert und visualisiert. In einer mobilen VR-Umgebung konnten sich Bürgerinnen und Bürger direkt vor Ort im Rahmen mehrerer Veranstaltungen über anstehende Stadtentwicklungsprojekte informieren und aktiv beteiligen. Mit großem Erfolg: Durch den Einsatz von Virtueller Realität konnten komplexe Sachverhalte verständlich und übersichtlich präsentiert werden. Bürgerinnen und Bürger, die zuvor nur schwer Zugang zu Beteiligungsformaten fanden wie Menschen mit Beeinträchtigungen, Migrationshintergrund oder Jugendliche, konnten so in diese Prozesse integriert werden. Aufgrund der positiven Resonanz und der guten Zusammenarbeit mit den Verantwortlichen der Stadt Herrenberg wird das Projekt „Digitaler Zwilling“ weiter vorangetrieben. So sollen im Rahmen zukünftiger Projekte neue Ebenen und Werkzeuge wie maschinelles Lernen, weitere Sensorik und soziale Daten integriert werden - und das nicht nur in Herrenberg, sondern auch in anderen Städten. (Weitere Informationen)

Jupyter-JSC: Supercomputing im Browser

Interaktives Supercomputing gewinnt derzeit an Bedeutung und damit auch die browser-basierte Entwicklungs-, Workflow- und Analyse-Webanwendung JupyterLab. Seit eineinhalb Jahren können die Nutzer der HPC-Cluster am JSC mit JupyterLab über https://jupyter-jsc.fz-juelich.de direkt aus ihrem Webbrowser auf JURECA und JUWELS zugreifen. Mit dem aktuellen Update des Jupyter-JSC-Dienstes ist auch der direkte Zugriff über den Browser auf die neuen HPC-Cluster DEEP-EST und JUSUF möglich. Jupyter-JSC ist kontinuierlich zu einem zuverlässigen Werkzeug herangereift. Im Hintergrund baut es auf den Software-Bausteinen JupyterHub, UNICORE und Unity-IdM auf und nutzt die Möglichkeiten der HDFCloud für eine 24/7-Verfügbarkeit und hohe Skalierbarkeit, z.B. für Workshops. Auf diese Weise kann jeder Nutzer der JSC-Systeme JupyterLab einfach und intuitiv direkt in seinem Webbrowser starten. Das jüngste Update des Jupyter-JSC-Dienstes bringt Unterstützung für weitere HPC-Cluster sowie viele neue Funktionen, wie z.B. mehr Konfigurationsoptionen beim Start, Unterstützung für Dashboards, ein einheitliches Design und natürlich Fehlerbehebungen und verbesserte Leistung. Vor allem aber kann Jupyter-JSC eines: Es kann schnell und zuverlässig ein modernes und funktionsreiches JupyterLab direkt auf den Rechenressourcen des JSC starten und ad-hoc für den Benutzer zugänglich machen.

LRZ installiert HPE-System Cray CS500 mit Fujitsu A64FX-Prozessoren

Als erstes akademisches Rechenzentrum in der EU nimmt das Leibniz-Rechenzentrum ein HPESystem Cray CS500 mit Fujitsu A64FX-Prozessoren auf ARM-Basis in Betrieb. Dabei handelt es sich um die gleiche Architektur wie bei dem japanischen Höchstleistungsrechner Fugaku, der den ersten Platz in der aktuellen Top500-Liste (Juni 2020) belegt. Die ARM-basierte Architektur in den Fujitsu-Prozessoren, die von Hewlett Packard Enterprise integriert wurde, soll sowohl für traditionelle Modellierungs- und Simulationsaufgaben, als auch für Datenanalysen, maschinelles Lernen und KI-Arbeitslasten geeignet sein. Sie wird in den nächsten Wochen in die LRZ-Testumgebung „BEAST“ (Bavarian Energy, Architecture and Software Testbed) integriert. Neben dem internen Testbetrieb, soll das System ab dem frühen Herbst für ausgewählte Projekte wie auch für die nächste Generation von HPC-Anwendern zur Verfügung stehen. Anwender haben so die Möglichkeit, die Performance der Fujitsu A64FX-Prozessoren im Alltag mit GPUs und mit üblichen CPUs zu vergleichen. Das LRZ als Rechenzentrum interessiert sich zudem besonders dafür, welche Rechenleistung pro Watt das System liefert.

© HPE/CRAY

HLRS: Jahresbericht 2019 verfügbar

Seit Anfang Mai ist der HLRS-Jahresbericht 2019 verfügbar, der die am HLRS stattgefundenen Aktivitäten und Geschehnisse des abgelaufenen Jahres rückblickend zusammenfasst. Berichtet wird darin u. a. über die vorbereitenden Maßnahmen, die das HLRS getroffen hat, um für den bevorstehenden Zusammenfluss von Hoch- und Höchstleistungsrechnen (High-Performance Computing, HPC) mit der Künstlichen Intelligenz gerüstet zu sein. Ein Interview mit Matthias Hauser, Direktor des ans HLRS angegliederten Media Solution Centers, beleuchtet das wachsende Interesse an der Interaktion von HPC und Kunst, und ein weiterer Schwerpunktartikel widmet sich dem Thema Dark Data in der Welt des HPC. Neben umfassenden Informationen über den nutzbringenden Einsatz der HLRS-Ressourcen in wissenschaftlichen und industriellen Forschungsprojekten und die Beschreibung der dabei erzielten Ergebnisse stellt die 2019er Ausgabe zudem neue, vom HLRS im letzten Kalenderjahr eingegangene Kooperationen vor. Der HLRS-Jahresbericht steht als pdf-Datei in englischer wie in deutscher Sprache zum Download bereit.