PUBLICATIONS

GCSnews 30/2020 (December 2020)

Diese GCSnews als pdf-Datei herunterladen

Europas schnellster Supercomputer JUWELS in Betrieb

Am 23. November wurde am Jülich Supercomputing Centre (JSC) die Erweiterung des Supercomputer JUWELS, das sog. JUWELS-Booster-Modul, in Betrieb genommen. Das neue Modul, das eng mit dem 2018 installierten JUWELS-Cluster-System verbunden ist, wurde von den Projektpartnern JSC, Atos, ParTec und NVIDIA entwickelt. Der JUWELS Booster weist eine Spitzenleistung von 73 PFLOPs auf und positionierte sich in der Top500-Liste als weltweit siebtschnellster Supercomputer und als Nummer 1 in Europa. Als einer der ersten ist er mit NVIDIA A100 Tensor Core GPUs ausgestattet. Etwa 12 Mio. sogenannte CUDA-Kerne (FP64) vereint der Booster auf seinen über 3.700 Grafikprozessoren, die über ein HDR-InfiniBand-Höchstleistungsnetz von NVIDIA Mellanox mit 200 Gb/s miteinander verbunden sind. Damit werden Simulationen mit noch höherer Auflösung und größerer Realitätsnähe ermöglicht. Auch für den Einsatz künstlicher Intelligenz ist das Modul gut ausgestattet. Bereits während der Installationsphase erhielten einige Anwendergruppen Zugriff auf den neuen Rechner, um Codes frühzeitig auf die neue Architektur zu portieren und wertvolle Rückmeldungen über die Systemfähigkeiten zu geben. JUWELS wird vom Bundesministerium für Bildung und Forschung und dem Ministerium für Kultur und Wissenschaft des Landes Nordrhein-Westfalen gefördert. Weitere Informationen: https://fz-juelich.de/ias/jsc/juwels.

GCS-Supercomputer in den TOP500

Der um ein neues Booster-Modul erweiterte GCS-Supercomputer JUWELS des Jülich Supercomputing Centres (JSC) ist aktuell der schnellste Höchstleistungsrechner Europas. In der neuesten TOP500-Liste (Nov. 2020) der weltweit leistungsfähigsten Supercomputer belegt JUWELS mit erzielten 44,1 Petaflops im Linpack (HPL)-Benchmarktest den 7. Rang, zudem rangiert JUWELS auf der aktuelle Green500-Liste auf Platz 3 und ist somit das energieeffizienteste System in der höchsten Leistungsklasse. Auch die beiden anderen GCS-Höchstleistungsrechner reihen sich in die Top-20 der weltweit schnellsten HPC-Systeme ein: Der SuperMUC-NG des Leibniz-Rechenzentrums in Garching (LRZ) liegt mit seiner Leistung von 19,5 PFlops im HPL-Benchmark auf Platz 15, direkt gefolgt vom HPC-System Hawk des Höchstleistungsrechenzentrums Stuttgart (HLRS) mit 19,3 PFlops. Auch in der zeitgleich veröffentlichten HPCG-Benchmark-Liste (High-Performance Conjugate Gradient – ein Test, der HPC-Systeme unter realen Anwendungsbedingungen misst) sind die drei GCS-Supercomputer gut positioniert mitJUWELS auf Platz 5, Hawk auf Platz 18 und SuperMUC-NG auf Platz 22. Weitere Informationen: https://top500.org/

Ergebnisse des 24. GCS Large-Scale Calls

Mit dem 24. GCS Call for Large-Scale Projects genehmigte das GCS-Rechenzeitkomitee insgesamt 16 neue, wissenschaftlich anspruchsvolle Simulationsprojekte, denen für einen Zeitraum von zwölf Monaten (November 2020 – Oktober 2021) großzügige Rechenzeitkontingente auf dem GCS-Höchstleistungsrechner SuperMUC-NG (LRZ) sowie den neu in Betrieb genommenen HPC-Systemen Hawk (am HLRS) und JUWELS Booster (am JSC) zugewiesen wurden. Die Inbetriebnahme der beiden neu hinzugekommenen GCS-Supercomputer, mit deren Aufbau am HLRS bzw. JSC bereits im Laufe des Jahres begonnen worden war, hatte sich aufgrund von Covid-19-bedingten Installations-Problematiken verzögert. Rechtzeitig zum Beginn der Bewilligungsphase des 24. Calls waren die beiden Höchstleistungsrechner jedoch betriebsbereit, sie bedienen nun 11 der 16 positiv bewerteten, wegweisenden Forschungsvorhaben. Darunter befindet sich das Simulationsprojekt, dem das individuell größte Rechenzeitkontingent zugewiesen wurde: Für seine Arbeit „Analysis of noise reduction by porous material, particulate flows and hot gas ingress in turbine wheel spaces” stehen Dr. Matthias Meinke vom Lehrstuhl für Strömungslehre und Aerodynamisches Institut (AIA) der RWTH Aachen University 780 Millionen Kernstunden Rechenzeit auf dem HLRS-Höchstleistungsrechner Hawk zur Verfügung. Die genehmigten Projekte des 24. GCS Large-Scale Calls repräsentieren eine Vielzahl wissenschaftlicher Disziplinen, die von der Strömungsmechanik über die Biophysik bis zur Elementarteilchenphysik reichen. Die vollständige Projektliste kann auf der GCS-Website eingesehen werden.

HLRS-Supercomputer Hawk wird ausgebaut

Das HLRS hat mit Systemlieferant Hewlett Packard Enterprise (HPE) ein Abkommen vereinbart, infolge dessen der HLRS-Supercomputer Hawk um 192 NVIDIA A100 Grafik-Prozessoren (GPUs) erweitert wird. Durch diesen Schritt wird dem HLRS-Höchstleistungsrechner, der aktuell auf Rang 16 in der Liste der schnellsten Supercomputer der Welt geführt wird (TOP500), 120 Petaflops an KI-Rechenleistung hinzufügt (KI = Künstliche Intelligenz). Zudem wandelt sich seine Architektur von einer reinen Zentralrechnertechnologie zu einer Hybrid-Plattform, wodurch er insbesondere für Deep Learning-Anwendungen optimiert sein wird. Neue Arten von Arbeitsabläufen, die Simulation unter Nutzung von Höchstleistungsrechnen (High-Performance Computing, HPC) mit Big-Data-Methoden kombinieren, werden damit möglich. HLRS-Nutzer haben somit fortan die Möglichkeit, Anwendungen aus dem Bereich des Deep-Learning, der Hochleistungsdatenanalyse und der KI auf ein und demselben System durchzuführen, das sie aktuell bereits für ihre höchst anspruchsvollen, rechenintensiven Simulationen nutzen: auf Hawk. (Weitere Informationen)

Neues europäisches Exzellenzzentrum für Quantenchemie

Zur Vorbereitung auf künftige Exascale-Systeme finanziert die Europäische Kommission Exzellenzzentren (Centre of Excellence CoE) für verschiedene Anwendungsbereiche. Zu den numerischen Methoden, die hinsichtlich ihrer Skalierbarkeit auf extrem parallelen Supercomputern besonders vielversprechend sind, gehören die Quantum-Monte-Carlo-Methoden (QMC). Mit Hilfe fortschrittlicher und systematisch verbesserungsfähiger stochastischer Methoden kann eine Simulation vollständig konsistenter quantenmechanischer Elektronenprobleme realisiert werden. Das neue CoE TREX (Targeting Real Chemical Accuracy at the Exascale) bringt sowohl Fachwissenschaftler, die in Europa international anerkannte QMC-Codes entwickelt haben, als auch HPC-Experten, u.a. vom Jülich Supercomputer Centre, zusammen. Ziel ist es, diese Anwendungen für die kommenden Pre-Exascale- und Exascale-Systeme in Europa zu ermöglichen. Ein Schwerpunkt wird die Portierung dieser Codes auf verschiedene Typen von GPUs und die Entwicklung und Implementierung einer gemeinsamen Bibliothek für QMC, genannt QMCkl, sein. TREX bringt Partner aus sieben verschiedenen Ländern zusammen und wird von der Universität Twente in den Niederlanden koordiniert. Das Projekt begann am 1. Oktober 2020 und hat eine Laufzeit von drei Jahren. (Weitere Informationen)

ORCHESTRA: Kampf gegen Covid-19

Das HLRS ist Mitglied eines internationalen Projekts namens ORCHESTRA, das am 1. Dezember 2020 offiziell gestartet wurde. ORCHESTRA steht für „Connecting European Cohorts to Increase Common and Effective Response to SARS-CoV-2 Pandemic" und widmet sich der Zusammenführung von Kohorten in Europa zur raschen Informationsverbreitung im öffentlichen Gesundheitswesen sowie zur Ausarbeitung von Impfstrategien zu COVID-19. Das HLRS übernimmt dabei die Aufgabe, die Infrastruktur und innovative Datenmanagement-Lösungen für die Erfassung und Analyse von Patientendaten auf nationaler Ebene zu koordinieren und implementieren sowie den pan-europäischen Portaldienst zur Zusammenführung von Daten aus ganz Europa mitzuentwerfen. "Für einen Dateningenieur wird diese Arbeit eine technische Herausforderung zugleich aber auch sehr spannend sein, denn sie bietet eine großartige Möglichkeit, wertvolles und nützliches Fachwissen im Kampf gegen COVID-19 einzubringen. Durch die Zusammenführung von Kohortenanalyse und fortschrittlicher Datentechnologie erhalten Epidemiologinnen und Epidemiologen neue Einblicke in die Pandemie," erläutert Dr. Björn Schembera, der die Teilnahme des HLRS am ORCHESTRA-Projekt leitet. Das ORCHESTRA-Projekt, das von Prof. Evelina Tacconelli von der Universität von Verona geführt wird, hat eine Laufzeit von 3 Jahren und wird durch das Horizon2020-Förderprogramm mit 20 Millionen Euro gefördert. (Weitere Informationen)

Neues NIC-Exzellenzprojekt am JSC

Zweimal im Jahr vergibt die NIC-Rechenzeitkommission den Titel „NIC-Exzellenzprojekt“ an herausragende Simulationsprojekte. Im Oktober zeichnete die Kommission das Projekt „Dynamik in quantenmechanischen Vielteilchensystemen mittels neuronaler Netze und GPU-Beschleunigung“ von Dr. Markus Heyl (MPI für Physik komplexer Systeme, Dresden) aus. Die Schrödingergleichung beschreibt die Bewegung quantenmechanischer Systeme und damit aller Materie auf atomarer Skala. Allerdings ist die Schrödingergleichung für Vielteilchensysteme nicht geschlossen lösbar und numerische Lösungsansätze stoßen selbst auf Supercomputern ab einer bestimmten Systemgröße an ihre Grenzen. Innerhalb des Projekts wird daher eine neuartige Herangehensweise basierend auf Methoden des maschinellen Lernens verfolgt. Dabei wird der quantenmechanische Zustand eines Vielteilchensystems in einem künstlichen neuronalen Netz gespeichert und die Schrödingergleichung in eine Dynamik des neuronalen Netzes übersetzt. Zwar stellt auch dieser Ansatz eine enorme Rechenherausforderung dar, kann aber mittels moderner Grafikkarten bewältigt werden. Dieses Verfahren soll auf wichtige, aber bisher unzugängliche, Probleme angewandt werden wie das Alterungsverhalten in quantenmechanischen Gläsern. (Weitere Informationen)

Intelligente Datentransferplattform zur Unterstützung von COVID-19-Modellen

Innerhalb des EU-geförderten Projekts EXCELLERAT (European Centre of Excellence for Engineering Applications) unterstützt das HLRS in einer Forschungsgruppe gemeinsam mit dem IT-Dienstleister SSC-Services aus Böblingen das Bundesinstitut für Bevölkerungsforschung (BiB). Die Projektpartner haben eine intelligente Datentransferplattform entwickelt, mit dessen Hilfe das BiB Daten hochladen, Simulationen ausführen sowie entsprechende Auswertungen herunterladen kann. Die Plattform soll bei Berechnungen der Auslastung von Intensivstationen während der Corona Pandemie zum Einsatz kommen, wodurch sich die Belastung des Gesundheitssystems, insbesondere der Intensivstationen, realistisch abschätzen lässt. Die Entwicklung der intelligenten Datentransferplattform vereint die beiden Stärken der Projektpartner. Das HLRS, mit neuem Supercomputer Hawk, liefert die notwendige Rechenleistung für die Simulationsberechnung und SSC baut die Datenaustausch- und Transferplattform auf, um die Nutzung von Höchstleistungsrechnen zu vereinfachen und den Datentransfer effizienter zu gestalten.

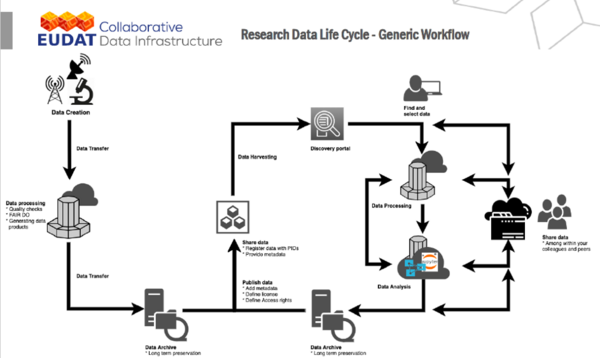

Europäische Werkzeuge für den Datenaustausch

Europa rückt zusammen – auch in der Wissenschaft und mit Hilfe von IT und Cloud: Die von der EU-Kommission und den Mitgliedsstaaten geplante europäische Cloud für eine offene Wissenschaft (European Open Science Cloud/EOSC) nimmt Gestalt an. Sie soll die technische Infrastruktur für die Zwischenspeicherung und Archivierung, für das Auffinden, den Zugang und den Austausch von Forschungsdaten liefern. Die EUDAT Collaborative Data Infrastructure (CDI), ein Netzwerk von mittlerweile 30 Rechen- und Datenzentren für Forschung und Lehre, entwickelt dafür Werkzeuge und Dienste. Inzwischen finden sich unter dem Dach von EUDAT CDI ein gutes Dutzend Open Source-basierter Programme und Tools, die der Astrophysiker und Datenverarbeitungs-Spezialist Johannes Reetz vom Rechenzentrum der Max-Planck-Gesellschaft MPCDF im September am Leibniz-Rechenzentrum (LRZ) präsentierte: „Ziel ist, EUDAT CDI als Layer zur Datenverwaltung und Speicherung für die entstehende European Open Science Cloud zu etablieren und diese dabei auch in bestehende europäische HPC-Infrastrukturen zu integrieren.“ Die Services und Projekte unterstützen vor allem die (langfristige) Datenspeicherung und das Datenmanagement. Als Partner europäischer Forschungsprojekte wie CompBioMed, GÉANT oder LEXIS greift das LRZ bereits auf EUDAT-Dienste zurück.

BEAST: Computertechnik für morgen

Im Rahmen seiner Initiative „Future Computing“ errichtete das LRZ die Experimentierumgebung „BEAST“. BEAST steht für „Bavarian Energy-, Architecture- and Software-Testbed“ und stellt zur Zeit AMD-Rome-Systeme und Server mit Marvell ThunderX2-Prozessoren sowie Graphikkarten als Beschleuniger bereit. Außerdem wurde ein Cray CS500-System installiert, das mit den gleichen A64FX-Prozessoren von Fujitsu arbeitet wie der weltweit schnellste Supercomputer Fugaku in Japan. „BEAST dient der Vorbereitung auf die nächste Generation von Supercomputern, also den Nachfolgern von SuperMUC-NG. Mit BEAST untersuchen wir, welche Computer-Architekturen sich zur Parallelisierung der Anwendungen unserer Nutzerinnen und Nutzern und für größere Systeme am besten eignen“, erklärt Laura Schulz, Stabsstelle für Strategische Entwicklung und Partnerschaften am LRZ. „Das ist eine wichtige Grundlage für unsere Planungen von zukünftigen Höchstleistungsrechnern.“ Der weitere Ausbau von BEAST ist bereits geplant. So sollen kurzfristig CPUs der aktuellen Intel-Xeon-Reihe (Cooper Lake und Ice Lake) in Dienst gestellt werden. Hier wurden einige neue Merkmale wie 16-Bit-Float (Bfloat16) für Gleitkommaoperationen implementiert, mit dem KI-Anwendungen signifikant beschleunigt werden können. Mittelfristig ist auch die Evaluierung von exotischeren Architekturen, wie FPGAs oder neuromorphen Ansätzen, geplant.

JURECA-DC am JSC in Betrieb genommen

Am 2. Dezember wurde am JSC das Nachfolgesystem des bisherigen JURECA-Clusters, das von Atos gelieferte sog. JURECA-DC-Modul (DC für „data centric“), in seiner ersten Ausbaustufe in Betrieb genommen. Die erste Phase von JURECA-DC besteht aus 384 Rechenknoten mit jeweils 128 AMD-EPYC-Rome-Kernen pro Knoten und 48 Knoten, die zusätzlich mit vier NVIDIA A100-GPUs ausgestattet sind. Damit enthält das System etwa zwei Drittel der CPU-Knoten der geplanten Endausbaustufe und 25 % der GPU-Knoten. Der vollständige Ausbau des Systems wird im Laufe des ersten Quartals 2021 zur Verfügung stehen. Im Vergleich zum Vorgängermodell werden in der Endausbaustufe alle wichtigen Systemleistungsindikatoren verbessert werden. Die Anzahl der Rechenknoten des Systems wurde um den Faktor 4, die Gesamtspeicherkapazität um 1,6 und die Spitzenleistung um ca. 7,8 erhöht; letzteres insbesondere aufgrund der größeren Anzahl von GPU-Knoten. Wie sein Vorgänger ist JURECA-DC eng mit dem JURECA-Booster verbunden, wodurch die gleichzeitige Nutzung aller Ressourcen innerhalb von Workflows sowie die gleiche parallele MPI-Anwendung ermöglicht wird. Während JURECA-DC für die bisherige Arbeitslast erhebliche Beschleunigungen bieten wird, ermöglichen mehrere innovative Funktionen eine effizientere Ausführung datenintensiver Arbeiten. Insbesondere wird das JURECA-DC-Modul eine neuartige systemintegrierte nichtflüchtige Speicherpartition enthalten - zusätzlich zum Zugriff mit hoher Bandbreite auf die JUST-Speicherschichten. Das JURECA-DC-Modul wurde im Rahmen des PPI4HPC-Projekts beschafft, das von der Europäischen Kommission durch einen gemeinsamen Beschaffungsprozess zusammen mit drei europäischen Partnerzentren kofinanziert wurde. Die Rechenzeit auf JURECA-DC wird überwiegend Helmholtz-intern und dabei besonders den Forschenden des Forschungszentrums Jülich zur Verfügung gestellt. Darüber hinaus wird ein Teil der Rechenzeit für europäische Wissenschaftler nutzbar sein. (Weitere Informationen)

HLRS und Fraunhofer IPA unterzeichnen Kooperationsvereinbarung

Enger noch als bisher wird das HLRS künftig mit dem Fraunhofer-Institut für Produktionstechnik und Automatisierung (Fraunhofer IPA) zusammenarbeiten. Eine im November 2020 unterzeichnete Kooperationsvereinbarung sieht vor, dem Fraunhofer IPA den Zugang zu den HPC-Systemen des HLRS zu erleichtern sowie das HPC-Knowhow des HLRS verstärkt zu nutzen. Auch sollen gemeinsame Interessen der beiden Partner im Rahmen der Kooperation gezielt angegangen werden, wie zum Beispiel die Nutzung von Höchstleistungsrechnen (High-Performance Computing/HPC) in der Industrie. Anwendungen aus dem Bereich des HPC haben in den letzten Jahren für die Forschung am Fraunhofer IPA zunehmend an Bedeutung gewonnen. Dazu zählen z. B. Analysen von großen Datensätzen, mithilfe derer sich Fertigungsprozesse verbessern lassen. Auch kann das Fraunhofer HPC nutzen, um die Genauigkeit von Anwendungen für maschinelles Lernen in der Kollaboration zwischen Mensch und Roboter zu überprüfen. Ein zusätzliches gemeinsames Ziel der eingegangenen Kooperation ist die weitere und effizientere Erschließung des Quantencomputing. (Weitere Informationen)

HPCwire-Awards für ausgezeichnete Forschung am LRZ

Auch in diesem Jahr wurden auf der SC20 die HPCwire Awards vergeben. Mit gleich zwei der Awards zeichneten die Leserinnen und Leser des Branchenmagazins das LRZ aus. In der Kategorie „Top Energy Efficiency HPC Achievement“ wurde die Wintermute-Extension zu dem im LRZ entwickelten Monitoring-Tool Data Centre Data Base ausgezeichnet. Wintermute ermöglicht es, einfach, effizient und ganzheitlich online die Betriebsdaten von großen HPC-Installationen zu analysieren. Alessio Netti entwickelt das Tool im Rahmen seiner Doktorarbeit am LRZ. Den zweiten Preis erhielt ein Team der Australian National Unversity um Christoph Federrath in der Kategorie „Top HPC-Enabled Scientific Achievement“. In Zusammenarbeit mit Kolleginnen und Kollegen am LRZ ist es dem Team gelungen, die größte jemals durchgeführte magnetohydrodynamische (MHD) Simulation astrophysikalischer Turbulenzen durchzuführen. Eine Übersicht aller Gewinner finden Sie hier.

Gewinner des HLRS Golden-Spike-Awards 2020

Anfang Oktober fand am HLRS zum 23. Mal der jährlich wiederkehrende HLRS Review and Results Workshop statt, der – wie alle aktuell anberaumten Veranstaltungen – online abgehalten wurde. Das Programm des Workshops umfasste 25 wissenschaftliche Vorträge sowie eine virtuelle Postersitzung mit 20 Beiträgen, mittels derer die Referenten die aktuellen Ergebnisse ihrer Simulationsprojekte aus einer Vielzahl wissenschaftlicher Disziplinen vorstellten, so z. B. aus dem Bereich der Strömungsmechanik, der Wetter- und Klimaforschung, den Materialwissenschaften, der Bioinformatik, der Physik sowie der Molekular- und Strukturmechanik. Im Rahmen der Veranstaltung wurden traditionell drei HLRS Golden Spike Awards für besonders herausragende Forschungsergebnisse im High Performance Computing vergeben. Die diesjährigen Auszeichnungen würdigen die Forschung zur Verbesserung der energetischen Effizienz im Flugverkehr durch Reduktion des Luftwiderstands an den Tragflächen und am Rumpf von Flugzeugen, die Entwicklung und Nutzung sehr hoch aufgelöster, regionaler Klimamodelle und das bessere Verständnis des Transports einer breiten Palette von Molekülen durch Zellmembranen in biologischen Systemen, was zum Beispiel die Wirksamkeit von Medikamenten entscheidend beeinflussen kann. Mit einem Golden Spike bedacht wurden Marian Albers vom Aerodynamischen Institut der RWTH Aachen Universität für seine Arbeit „Comparison of two airfoils for active drag reduction in turbulent flow”, Dr. Gerd Schädler vom Institut für Meteorologie und Klimaforschung am Karlsruher Institut für Technologie für seine Arbeit „Regional climate simulations with COSMO-CLM: CORDEX Africa and CORDEX FPS convection“, sowie Prof. Dr. Lars Schäfer vom Lehrstuhl für Theoretische Chemie der Ruhr-Universität Bochum für seine Arbeit „Caught in the act: all-atom molecular dynamics simulations of substrate transport in the ABC exporter TM287/288”. (Weitere Informationen)

FutureTech4Climate

Mitte November fand in München der Hackathon „FutureTech4Climate“ statt, veranstaltet vom Bayerischen Digitalministerium und von Bayern.innovativ. Das Leibniz-Rechenzentrum (LRZ) setzte dafür auf das Thema „Software, Sensoren und Supercomputer“ und stellte ein Team aus vier Betreuerinnen und Betreuer. Sieben von über 100 Schülerinnen und Schülern, Studierenden, Programmiererinnen und Programmierern sowie Klimabewussten, die vom 13. - 15. November in 18 Gruppen an Apps, Online-Marktplätzen und Software für nachhaltigen Konsum und Umweltschutz tüftelten, analysierten die Sensordaten und den Energieverbrauch von SuperMUC-NG und Anwendungen. Betreut von Laura Schulz und Alessio Netti vom LRZ sowie Amir Raoofy und Professor Martin Schulz von der Technischen Universität München lieferten sie drei praktikable Lösungen für den Einsatz erneuerbarer Energien, zur Prognose des Strombedarfs und zur Steuerung des Stromverbrauchs beim Supercomputing: „Sinn des Hackathons war, mit den Sensordaten von SuperMUC-NG zu arbeiten und die Ideen der Teilnehmenden zu nutzen“, sagt Laura Schulz, einer der LRZ-Betreuerinnen. Unter anderem entstand dabei die App Greencrease.ai, die Wetter- und Sensordaten verbindet, um den Einsatz erneuerbarer Energien beim Supercomputing zu ermöglichen. Diese Idee wurde beim bayerischen Digitalgipfel als Lösung „mit dem größten Einsparpotenzial von CO2“ ausgezeichnet. (Weitere Informationen)

SuperMUC-NG für gutes Klima

Die Bemühungen um Nachhaltigkeit und Klimaschutz standen im Mittelpunkt des Beitrags des LRZ auf dem Innovationstag der Vereinigung der Bayerischen Wirtschaft vbw: Neben den Mozilla-Hubs und Visualisierungen zu Umweltprojekten präsentierte das LRZ hier auch die innovative Warmwasser-Kühlung seiner Computersysteme, die durch Eingriffe in technische Betriebsparameter wie Temperatur, Wassermengen und Pumpengeschwindigkeit weiter an Effizienz gewinnt. Ganz ähnlich werden auch die smarten Steuerungen, die auf der Basis von DCDB und Wintermute entstehen, zur Reduktion des Stromverbrauchs am LRZ beitragen. Als nachhaltig erweisen sich übrigens auch die Online-Konferenzen und Messen: Sie können wie die LRZ-Mozilla Hubs noch immer in aller Ruhe besucht werden. (Weitere Informationen)

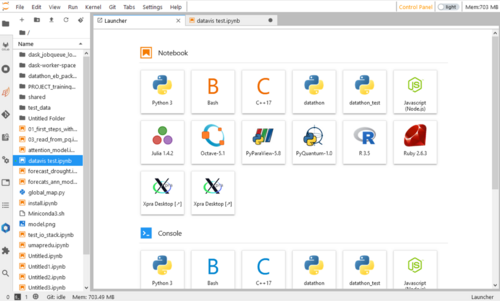

JSC unterstützt HIDA-Datathon

Im November 2020 unterstützte das JSC erstmalig einen Datathon der Helmholtz Information & Data Science Academy (HIDA). Aufgabe der Teilnehmenden des Datathons war es, eine von fünf Problemstellungen, die von verschiedenen Helmholtz-Zentren vorgeschlagen wurden, mit Mitteln der Datenanalyse, des maschinellen Lernens und der Datenvisualisierung an zwei Tagen zu bearbeiten. Die Themen des Datathons hatten in diesem Jahr einen Bezug zum Klimawandel. Die besten Ideen und Ausarbeitungen wurden von einer Jury bewertet. Zur Unterstützung des Datathons und der über 90 Teilnehmer aus sieben Ländern − rund die Hälfte der Teilnehmer kamen dabei von 12 Helmholtz-Zentren − stellte das JSC, wie auch das Steinbuch Centre for Supercomputing (SCC) des KIT, Ressourcen auf dem Supercomputer JUSUF der Fenix-Infrastruktur zur Verfügung und begleitete im technischen Support die Vorbereitung und die Durchführung des Events. Für einen unkomplizierten Zugang auf die Systeme kam hierbei das Jupyter-Angebot des JSCs zum Einsatz, welches den Teilnehmenden einen webbasierten Zugang zu den Systemen und eine einfache Möglichkeit der Datenanalyse und Aufbereitung bot. Aufgrund des großen Erfolgs der Veranstaltung ist eine Wiederholung im kommenden Jahr geplant. (Weitere Informationen)