PUBLICATIONS

GCSnews 33/2021 (September 2021)

Diese GCSnews als pdf-Datei herunterladen

HLRS-Rechner Hawk jetzt mit Partition für Künstliche Intelligenz

Das HLRS hat die Erweiterung seines Supercomputers Hawk um eine Partition für Künstliche Intelligenz (KI) abgeschlossen. 192 NVIDIA A100 Grafik-Prozessoren (GPUs), die auf der NVIDIA Ampere Architektur basieren, wurden installiert und für den operativen Betrieb freigegeben. Durch die Erweiterung von Hawk, die eine KI-Leistung von 120 Petaflops bietet, wandelte sich die Rechnerarchitektur des HLRS-Supercomputers von einer reinen Zentralrechnertechnologie zu einer Hybrid-Plattform, wodurch er insbesondere für Deep-Learning-Anwendungen optimiert ist. Neue Arten von Arbeitsabläufen, die Simulation unter Nutzung von Höchstleistungsrechnen (High-Performance Computing, HPC) mit Big-Data-Methoden kombinieren, sind damit nun möglich. Mit der Integration von GPUs in die bestehende CPU-Infrastruktur von Hawk freuen sich Informatiker:innen am HLRS auch auf die Zusammenarbeit mit seinen Systemnutzer:innen bei der Entwicklung neuer hybrider Rechen-Workflows, die traditionelle Simulationsmethoden mit KI-Ansätzen integrieren. (Weitere Informationen)

Gemeinsames virtuelles Labor AIDAS von CEA und FZJ implementiert

Das Forschungszentrum Jülich (FZJ) und die CEA Paris bündeln ihre Kräfte und werden ihre Zusammenarbeit auf dem Gebiet der künstlichen Intelligenz, Datenanalyse und skalierbaren Simulation (AIDAS) ausbauen. Zu diesem Zweck unterzeichneten François Jacq, Generaladministrator der französischen Kommission für alternative Energien und Atomenergie (CEA), und Prof. Wolfgang Marquardt, Vorstandsvorsitzender des FZJ, eine Vereinbarung für das gemeinsame virtuelle Labor AIDAS. Ziel von AIDAS ist es, die Simulation in Europa voranzubringen, indem die Partner ihr Fachwissen im Bereich der Numerik mit Blick auf Künstliche Intelligenz (KI), Quantencomputing und Hoch- und Höchstleistungsrechnen (HPC) zusammenführen. Bislang sind rund 70 Wissenschaftler in AIDAS vertreten. Das Labor wird von Christophe Calvin und France Boillod-Cerneux vom CEA und Prof. Thomas Lippert und Prof. Kristel Michielsen vom Jülich Supercomputing Centre am FZJ geleitet. – CEA und FZJ arbeiten seit langem auf dem Gebiet des HPC zusammen, sowohl in HPC-basierten Anwendungsbereichen als auch bei der Entwicklung von HPC-Spitzentechnologien in Europa. Im Rahmen von AIDAS werden sie skalierbare und optimierte Anwendungscodes in ausgewählten wissenschaftlichen Bereichen entwickeln, den potenziellen Nutzer:innen neuer und zukünftiger Computerarchitekturen erforschen und die synergetische interdisziplinäre Entwicklung und Nutzung von generischen Methoden und Algorithmen für das Exascale Computing fördern. Darüber hinaus sollen attraktive Programmier- und Benutzerumgebungen entwickelt werden.

Erdbeobachtungsdaten für die Forschung: terrabyte

terrabyte ist die innovative Hochleistungsdaten-Plattform des Deutschen Zentrums für Luft- und Raumfahrt (DLR) und des Leibniz-Rechenzentrums (LRZ) der Bayerischen Akademie der Wissenschaften. Die Plattform macht Erdbeobachtungsdaten für die Forschung zugänglich und bietet praktische Werkzeuge zu deren Auswertung: (1) Sie verbindet über eine 10 Gigabit/s-Leitung das Satellitendaten-Archiv des Deutschen Zentrums für Luft- und Raumfahrt (DLR) in Oberpfaffenhofen mit intelligent verwaltetem Online-Speicherplatz von rund 50 Petabyte sowie den Supercomputern des LRZ in Garching. (2) Sie bietet eine Alternative zu kommerziellen Daten-Clouds und erfüllt alle Sicherheits- und Datenschutz-Forderungen. (3) Die Daten von terrabyte sollen breit genutzt werden, neben dem DLR werden bald auch die Universitäten in München und Bayern darauf zugreifen. „Wir übertragen intern die Daten mit 300 Gigabyte pro Sekunde, das eröffnet neue Möglichkeiten für ihre Prozessierung“, sagt Dieter Kranzlmüller, Leiter des LRZ. „Die Zusammenarbeit mit dem DLR ist eine willkommene Herausforderung für uns. Bei terrabyte geht es nicht nur um sehr große Rechenkapazitäten, sondern vor allem um die Verarbeitung von Massendaten. Die Plattform zeigt außerdem die wachsende Bedeutung von Speichervolumen für die Forschung. In immer mehr Wissenschaftsbereichen sollen Daten heute unkompliziert erreichbar sein und idealerweise vor Ort verarbeitet werden.“ Extremwetter, Dürren, schmelzende Gletscher, die Erosion der Küsten, sogar die Entwicklung von Städten: Zurzeit senden acht Copernicus Sentinel-, die US-amerikanischen Landsat sowie die Radar-Satelliten des DLR pro Tag rund 19 Terabyte an Daten über den aktuellen Zustand der Erde zu uns. Das entspricht in etwa 4750 Spielfilmen oder 123,5 Millionen Dokumentseiten. (Weitere Informationen)

Künstliche Intelligenz für eine sichere Automatisierung

Festo, ein im baden-württembergischen Esslingen ansässiger Hersteller von Automatisierungslösungen, erhöht seine Investitionen in maschinelles Lernen, wozu es eine Kooperation mit dem HLRS eingegangen ist. Festo trainiert Roboter aus dem Automatisierungsbereich auf den sichereren, effizienteren Umgang mit Menschen, indem es zur Verbesserung seines Algorithmus reinforcement learning verwendet, d. h. ihn durch Feedback zu seinen Entscheidungen trainiert. Dieses Training bedarf neben etwa 70 bis 100 Terabyte an Daten auch GPU-Beschleuniger und der entsprechenden Erfahrung mit umfangreichen Simulationen. Hierzu greift Festo auf die HPC-Ressourcen und HPC-Expertise des HLRS zurück. Das Team wird nicht nur die „Intelligenz“ des Algorithmus durch effektives Training erhöhen, sondern sich auch auf die Sammlung aussagekräftiger Datensätze aus den Simulationen mit Robotern und aus Experimenten im Forschungs- und Entwicklungslabor von Festo fokussieren. Letztere bilden die Basis für die Vorstellung und Konzeption neuer Arbeits- und Interaktionsmöglichkeiten von Mensch und Maschine. Schließlich wird das Team die Anwendungsmöglichkeiten der mithilfe der HLRS-Ressourcen gewonnenen Erkenntnisse und Daten auf reale Fertigungsszenarien optimieren. (Weitere Informationen)

Positionspapier zu HPC-Technologien von morgen

High-Performance Computing ist an einem Wendepunkt: So überschrieb es ein IT-Journalist und bezieht sich damit auf ein Positionspapier zur vom LRZ vorgeschlagenen integrierten Supercomputer-Architektur, das Prof. Dr. Martin Schulz beim 11. Symposium on Highly Efficient Accelerators and Reconfigurable Techologies, HEART, vorstellte. Der LRZ-Direktor und seine Co-Autor:innen – u.a. LRZ-Leiter Prof. Dr. Dieter Kranzlmüller – liefern in ihrer Schrift Vorstellungen davon, wie die Zukunft des Rechnens aussehen könnte. Die Autor:innen legen darin Schwachstellen aktueller High-Performance-Computing- (HPC) Systeme offen. Beispielsweise kostet der Datentransfer nicht nur Zeit, sondern auch viel Energie. Ferner benötigen neue Forschungsgruppen wie z. B. aus den Bereichen Machine Learning, Data Analytics oder der Simulation des Quantencomputings heterogenere und flexiblere Architekturen. So wäre es laut den Autor:innen ideal, wenn unterschiedliche Rechenelemente wie ARM-Rechenkerne, Grafik-Prozessoren (GPUs) und Tensor Units direkt mit anderen auf dem gleichen Chip zur Verfügung stünden, wie dies die European Processor Inititive (EPI) untersucht. Dadurch wachsen aber auch die Anforderungen an die Programmierung dieser HPC-Systeme. Die Veröffentlichung stellt vor, wie diese Systeme aussehen und wie sie programmiert werden könnten. (Weitere Informationen)

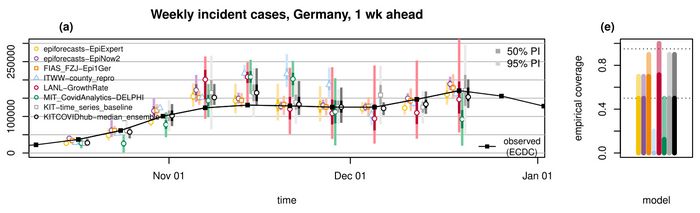

Herausforderungen bei der Vorhersage von COVID-19

Kurzfristige Vorhersagen der COVID-19-Fallzahlen für einen Zeitraum von 1 bis 4 Wochen können ein wertvolles Instrument sein, um zu entscheiden, welche Maßnahmen erforderlich sind, um eine Überbelegung von Krankenhausbetten und Intensivstationen zu verhindern. Aber wie gut ist die Qualität dieser Vorhersagen? Im Artikel "A pre-registered short-term forecasting study of COVID-19 in Germany and Poland during the second wave", veröffentlicht in Nature Communication (Bracher et al., DOI: 10.1038/s41467-021-25207-0), analysieren Jan Meinke und Jan Fuhrmann vom JSC zusammen mit Kolleg:innen aus Europa und den USA ihre Vorhersagen, die für Deutschland und Polen im Rahmen des deutsch-polnischen Vorhersagezentrums während der zweiten Welle von COVID-19 (12. Oktober - 19. Dezember 2020) gesammelt wurden. Die Leistung der Einzelvorhersagen wird mit der Qualität von Ensemblevorhersagen verglichen, die die Einzelvorhersagen kombinieren. Das Konfidenzintervall der Ensemble-Vorhersage bietet eine gute Abdeckung, d. h. das 50%-Konfidenzintervall deckt etwa 50% der Daten ab. Die Vorhersagen des Ensembles sind konkurrenzfähig mit der besten Einzelmodellvorhersage und scheinen weniger anfällig für Ausreißer zu sein. Die Beiträge zur deutsch-polnischen Vorhersage sind nun auch im European Covid-19 Forecast Hub enthalten.

Forschungsprojekte am LRZ zum Thema Wasserqualität

Schadstoffe nachweisen und die Versorgung sichern: Wasser ist ein kostbares Gut, nach den letzten trockenen Sommern kommt diese Erkenntnis immer stärker in unserem Alltag an. Das Leibniz-Rechenzentrum (LRZ) ist an zwei kürzlich gestarteten Forschungsprojekten mit dem Schwerpunktthema Wasser beteiligt. K2I oder „Künstliche und kollektive Intelligenz zum Spurenstoff-Tracking in Oberflächenwasser für eine nachhaltige Trinkwassergewinnung“ wird vom Bundesministerium für Bildung und Forschung (BMBF) mit knapp einer Million Euro finanziert (Förderkennzeichen 02WDG1593A-D) und will mit Methoden der Künstlichen Intelligenz (KI) ein smartes System zur Bewertung von Wasserqualitäten sowie zur Warnung gegen Verschmutzung aufbauen. Die Studie „Nutzwasser“ erforscht wiederum Konzepte und Managementstrategien für die Wiederverwendung von Abwasser als alternative Ressource für die Bewässerung in Städten und auf dem Land. (Weitere Informationen)

© istockphoto.com/Valery Brozhinsky

Zehn Jahre Nachhaltigkeitsstrategie am HLRS

Vor zehn Jahren begann das intensive Engagement des HLRS für Umweltschutz. Zu seinem Umweltmanagementplan gehören der effiziente Betrieb der Rechner- und Kühlsysteme und die Integration von Nachhaltigkeitsaspekten in das gesamte Zentrum. Zudem verpflichtet sich das HLRS, seine Umweltleistung kontinuierlich zu verbessern und seine Expertise mit anderen Datenzentren zu teilen, etwa mit dem Praxisleitfaden „Nachhaltigkeit in Rechenzentren“. 2020 hat das HLRS erstmals die Zertifizierung nach dem Eco-Management and Audit Scheme (EMAS) und dem Umweltzeichen Blauer Engel erhalten. Auch die aktuelle Planung für ein neues Rechnergebäude erfolgt unter Nachhaltigkeitsaspekten. Zwei neue Forschungsprojekte greifen dies ebenso auf. So wird das vom Ministerium für Umwelt, Klima und Energiewirtschaft Baden-Württemberg geförderte Projekt ENRICH (Energie, Nachhaltigkeit, Ressourceneffizienz in IT und Rechenzentren) einen digitalen Atlas mit Möglichkeiten zur Steigerung der Energieeffizienz im IT-Sektor in dem Bundesland entwickeln. Außerdem wird das HLRS mit dem Stuttgarter Institut für Gebäudeenergetik, Thermotechnik und Energiespeicherung zusammenarbeiten, um neue Ansätze für die dynamische Regulierung der Kühlung seines Supercomputers Hawk zu testen. (Weitere Informationen)

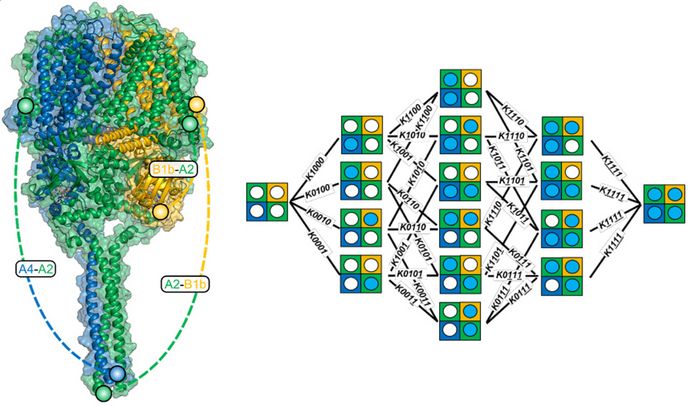

Entwirrung des Schaltverhaltens von Membranrezeptoren

Molekulare Rezeptoren in Membranen steuern viele Vorgänge in lebenden Zellen und sind Ziele für Medikamente. Membranrezeptoren werden durch die Bindung von Botenstoffen, so genannten Liganden, aktiviert. Viele Membranrezeptoren setzen sich aus verschiedenen Untereinheiten zusammen, von denen jede einen Liganden binden kann. Das macht den Aktivierungsmechanismus komplex. In der aktuellen Veröffentlichung "Thermodynamic profile of mutual subunit control in a heteromeric receptor" (DOI: 10.1073/pnas.2100469118) in den Proceedings of the National Academy of Sciences USA haben Wissenschaftler:innen um Prof. Holger Gohlke vom JSC am Forschungszentrum Jülich und der Heinrich-Heine-Universität Düsseldorf, Prof. Klaus Benndorf vom Universitätsklinikum Jena und Prof. Eckhard Schulz von der Hochschule Schmalkalden eine sehr originelle Funktionsanalyse des Schaltverhaltens des tetrameren CNG-Kanals durchgeführt, der am Geruchssinn beteiligt ist. Der Kanal besteht aus vier Untereinheiten, die die Autor:innen miteinander verknüpften, so dass sich 12 Konfigurationen mit permutierter Untereinheitsreihenfolge ergaben. Die Gruppe um Gohlke half mit molekularen Simulationen auf dem JSC-Supercomputer JUWELS, die wahrscheinlichste räumliche Anordnung der Untereinheiten zu verstehen. (Weitere Informationen)

Links: Strukturmodell eines A4-A2-B1b-A2 CNG-Ionenkanals. Rechts: Ein heterotetrameres allosterisches Modell mit 16 Bindungszuständen des Ionenkanals, die durch 32 Gleichgewichtsassoziationskonstanten (Kxxxx) verknüpft sind, die im Rahmen dieser Forschungsarbeit bestimmt wurden. © Univ. Jena / Klaus Benndorf

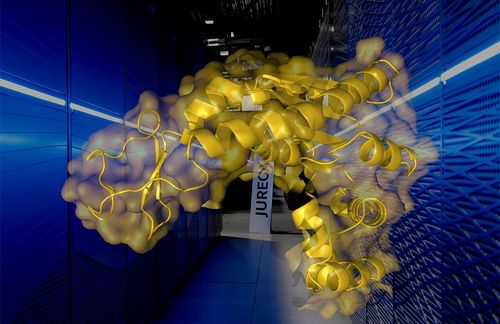

Interpretation biomolekularer Daten mit Hilfe von Schwarmintelligenz

Die detaillierte Struktur von Biomolekülen spielt eine Schlüsselrolle für ihre entscheidenden Funktionen und Wechselwirkungen im menschlichen Körper. Um beispielsweise neue Medikamente zu entwickeln, müssen Forscher diese Strukturen zunächst kennen und in komplexen Experimenten bestimmen. Die aus den Experimenten gewonnenen Daten sind jedoch manchmal nicht eindeutig und können nicht einer bestimmten Struktur zugeordnet werden. Wissenschaftler des Jülich Supercomputing Centre (JSC), des Karlsruher Instituts für Technologie (KIT), des Deutschen Krebsforschungszentrums (DKFZ) und der Universität Duisburg/Essen haben gemeinsam eine KI-basierte Methode entwickelt, um solche mehrdeutigen Daten mit Hilfe von datengetriebenen Molekülsimulationen auszuwerten. Diese Methode basiert auf dem Schwarmlernen der KI-Forschung. Ein Supercomputer simuliert viele Schwarmmitglieder gleichzeitig auf über 1000 Prozessoren. Jedes Mitglied testet verschiedene Parameterkombinationen und Gewichtungen der experimentellen Daten mit einem komplementären physikalisch basierten Computermodell. Laut Marie Weiel, Doktorandin und Hauptautorin der Studie, ist ein entscheidender Bestandteil die Kommunikation zwischen den Schwarmmitgliedern, um gemeinsam eine optimale Lösung zu finden, die für die bestmögliche Interpretation der Daten als molekulare Strukturen unerlässlich ist. Die Methode liefert somit sehr genaue Strukturen und nutzt gleichzeitig die verfügbaren Rechenressourcen - in diesem Fall u.a. den JSC-Höchstleistungsrechner JUWELS und den HPC-Cluster am KIT - sehr effizient. Die Ergebnisse wurden in der Zeitschrift Nature Machine Intelligence veröffentlicht (DOI: 10.1038/s42256-021-00366-3)

Biomoleküle sind eine Art Schweizer Taschenmesser für unseren Körper und erfüllen eine Vielzahl komplexer und wichtiger Aufgaben. Das hervorgehobene Protein ist an der Energiebilanz einer Zelle beteiligt, indem es den Energieträger ATP reguliert. Im Hintergrund ist das neue Modul des JSC-Supercomputers zu sehen, mit dem ein Teil der Analysen durchgeführt wurde. © FZJ

JSC-Rechenressourcen ermöglichen bahnbrechende Turbulenz-Simulationen

Extremereignisse wie heftige Tornados und starke Fluten sind zwar selten, ihre Erforschung ist jedoch aufgrund der unverhältnismäßig starken Wirkungen besonders wichtig. Die Vorhersage solcher extremen Ereignisse, die im Kontext dynamischer Systeme auch als Intermittenz bezeichnet werden, ist eine große Herausforderung. In jeder turbulenten Strömung treten extreme Fluktuationen auf, wobei deren Intensität mit steigender Reynoldszahl zunimmt. Mithilfe hochaufgelöster und hochakkurater Strömungssimulationen haben Michael Gauding (Universität Rouen) und Mathis Bode (RWTH Aachen University) federführend Intermittenz in Scherströmungen untersucht. Sie unterscheiden dabei zwischen interner Intermittenz, die auf kleinsten Skalen auftritt und ein charakteristisches Merkmal jeder vollentwickelten turbulenten Strömung ist, und externer Intermittenz, die sich am Rand freier Scherströmungen manifestiert. Mit den auf den Höchstleistungsrechnern des Jülich Supercomputing Centre durchgeführten Simulationen gelang es den Forschern erstmals, eine Kopplung zwischen interner und externer Intermittenz nachzuweisen, diese zu quantifizieren und in die klassische Turbulenztheorie einzubauen. Dies ist ein wichtiger Schritt für die Vorhersage derartiger Extremereignisse. (Weitere Informationen)

MPI und das nächste Leistungslevel fürs High-Performance Computing

Das Message Passing Interface (MPI) stand im Mittelpunkt der diesjährigen EuroMPI-Konferenz, die am 7. September 2021 mit dem Leibniz-Rechenzentrum (LRZ) als virtuellem Gastgeber ausschließlich online stattfand. Anwender:innen und Forschende diskutierten hier über neu vorgeschlagene Konzepte des Programmierschemas und zu den Erweiterungen des MPI-Standards, über Bibliotheken und Sprachen, die auf MPI aufbauen, außerdem über notwendige Schnittstellen zu anderen Standards in der parallelen Programmierung. Natürlich ging es auch um Anwendungen und deren Anpassungen an neue, leistungsfähigere Rechner-Architekturen und Netzwerke: MPI goes Exascale. In diesem Jahr zeichnete Prof. Dr. Martin Schulz, Direktor am LRZ, für das Programm der EuroMPI verantwortlich. Das vierte Major Release MPI-4 erschien im Juni 2021 und enthält etwa 150 neue Funktionen und Methoden, die die Nutzung sehr vieler Prozessoren schneller und effizienter machen. Die Anzahl der kommunizierenden Elemente wurde auf über zwei Milliarden erhöht und die Fehlerkorrektur verbessert. Im Anschluss traf sich das MPI Forum, das sich mit Verbesserungsvorschlägen für MPI-4 beschäftigte. (Weitere Informationen)

Zum 2. Mal virtueller PRACE Summer of HPC am JSC

Das Programm "Summer of HPC" (SoHPC), das bereits zum 9. Mal stattfand, ermöglichte es über 60 Universitätsstudierenden aller wissenschaftlichen Disziplinen, zwei Monate lang mit PRACE-Partnerorganisationen zusammenzuarbeiten. Ziel des SoHPC-Programms ist es nicht nur, den Studierenden die Möglichkeit zu geben, in einem multidisziplinären und internationalen Umfeld an Forschungsprojekten zu arbeiten, sondern auch, die wissenschaftliche Kultur unter der nächsten Generation von Forschenden zu fördern und zu verbreiten. Damit soll erreicht werden, dass die am Programm teilnehmenden Studierenden die Computerwissenschaftler:innen von morgen sind. Die Teilnehmer:innen teilen ihre Erfahrungen in Blogs und Videopräsentationen mit anderen und werden so selbst zu Botschafter:innen des Supercomputing an ihren jeweiligen Einrichtungen.

In diesem Jahr wurden innerhalb des virtuell durchgeführten Programms drei Studenten, nämlich Arthur Guillec (Frankreich), Tristan Michel (Frankreich) und Marc Túnica (Spanien), vom JSC betreut, um Erfahrungen im Forschungsalltag aus erster Hand zu sammeln. Nach einer Online-Schulungswoche für alle Studierenden, die vom Irish Centre for High-End Computing in Dublin veranstaltet wurde, begannen die drei Studenten gemeinsam mit der Arbeit an den ihnen zugewiesenen Projekten am JSC. Arthur und Tristan arbeiteten an der Parallelisierung der Fast Multipole Methode mit HPX, während Marc sich mit High Performance Quantum Fields beschäftigte. Ihre Ergebnisse stellten sie in zwei Videopräsentationen vor, die unter https://bit.ly/3C1PoqS und https://bit.ly/3lEk7Uv zu finden sind.