PUBLICATIONS

GCSnews 34/2021 (Dezember 2021)

Diese GCSnews als pdf-Datei herunterladen

TOP500, November 2021: JUWELS-Booster des JSC bleibt schnellster Supercomputer Europas

Am Eröffnungstag der SC21 wurde die inzwischen 58. Ausgabe der TOP500 publiziert, die die größten High-Performance Computing (HPC) Systeme der Welt anhand ihrer mit dem High-Performance Linpack (HPL) Benchmark erzielten Leistung führt. Das JUWELS-Booster-System des Jülich Supercomputing Centre (JSC) ist demzufolge weiterhin der schnellste Supercomputer Europas. Mit seiner theoretischen Spitzenleistung von 71 Petaflops rangiert das von Atos gelieferte Jülicher Rechnersystem in den aktuellen TOP500 auf Rang 8. Auf den ersten zehn Plätzen in der aktuellen TOP500-Liste gab es nur wenige Veränderungen. Der weltweit leistungsfähigste Supercomputer ist weiterhin der von RIKEN und Fujitsu mitentwickelte Supercomputer Fugaku am japanischen RIKEN Center for Computational Science mit einem HPL-Benchmarkwert von 442 Petaflops. Das Perlmutter-System am NERSC (USA) auf Platz 5 konnte seine gemessene Linpack-Leistung leicht verbessern. Neu hinzugekommen ist auf Platz 10 das bei Microsoft (USA) installierte Voyager-EUS2-System mit 30,05 PetaFlop/s. (Weitere Informationen)

GCS-Zentren auf der Supercomputing Conference 2021 (SC21)

Die Supercomputing Conference (SC), die größte jährlich stattfindende Konferenz und Ausstellung im Bereich des High-Performance Computing, fand dieses Jahr vom 14. bis 19. November in St. Louis, Missouri als Hybrid-Event statt. Besuchern wie Ausstellern und Konferenzprogramm-Mitwirkenden war es somit ermöglicht, auf der SC21 entweder virtuell oder live vor Ort vertreten zu sein. Aufgrund der pandemiebedingten Planungsunsicherheiten hatten sich die drei GCS-Zentren Höchstleistungsrechenzentrum Stuttgart (HLRS), Jülich Supercomputing Centre (JSC) und Leibniz Rechenzentrum in Garching (LRZ) allesamt für eine ausschließlich virtuelle Teilnahme entschieden.

Das HLRS hatte für die SC21-Konferenz gemeinsam mit dem HiDALGO Centre of Excellence einen virtuellen Stand geschaffen. Sein SC21-Programm beinhaltete Themen von der COVID-19-Forschung bis hin zu Entwicklungen im europäischen HPC-Umfeld und der Simulation von Naturkatastrophen. Insgesamt nutzten mehr als 120 Personen die vom HLRS gebotenen Aktivitäten.

Das JSC, das sich auf der SC21 gemeinsam mit seinen Partnern ParTec und der Jülich Aachen Research Alliance (JARA) ebenfalls auf einem virtuellen Stand präsentierte, hatte u. A. zu einem virtuellen SC21 Get-Together geladen. Unter der Leitung von JSC-Direktor Prof. Dr. Thomas Lippert wurden im Rahmen dieser Veranstaltung Einblicke in spannende Aktivitäten am JSC auf dem Weg zum Exascale-Computing gewährt. Dies und die anschließende Möglichkeit, mit JSC-Vertretern über verschiedene Themen zu diskutieren, war alleine von rund 65 Personen wahrgenommen worden.

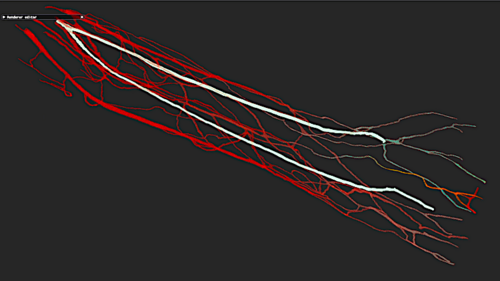

Das LRZ hatte seinen SC21-Auftritt unter den Slogan „Science and Beyond – How LRZ supports ground-breaking research“ gestellt. Auf seiner virtuellen Präsentationsplattform erhielten Besucher:innen Zugang zu den von LRZ-Vertretern mitgestalteten SC-Sessions zu Themen rund um die Zukunft des HPC. Zudem wurden Links zu Präsentationen angeboten, mittels derer SuperMUC-Nutzer ihre Forschungsarbeiten aus div. Wissenschaftsgebieten vorstellten. Ein SC21-Highlight des LRZ war die Visualisierung des Blutflusses in den Venen und Arterien eines Unterarms – eine Arbeit von LRZ-Mitarbeiterin Elisabeth Mayer und ihren Kollegen, die es ins Finale des Wettbewerbs Scientific Visualization Showcase geschafft hatte.

Die ausführlichen Programmpunkte und jeweiligen Aktivitäten der GCS-Zentren auf der SC21 sind online einsehbar unter HLRS@SC21, JSC@SC21, LRZ@SC21

25 Jahre Innovation: Das HLRS feiert Jubiläum

Mit einer hybriden Online-/Offline-Veranstaltung feierte das HLRS am 6. Oktober 2021 sein 25-jähriges Bestehen. Seit seiner Gründung 1996 hat sich das HLRS zu einem international bedeutenden Forschungszentrum entwickelt. Bei der Jubiläumsfeier brachte das Zentrum enge Partner zusammen, um die Beiträge des HLRS zu Wissenschaft und industrieller Forschung sowie Entwicklung zu betrachten. Den Podiumsdiskussionen des Vormittags, in denen wichtige Aspekte der Geschichte und der Aktivitäten des Höchstleistungsrechenzentrums erörtert wurde, folgte am späten Nachmittag ein Festakt. Zu den anwesenden und online zugeschalteten Ehrengästen zählten der Rektor der Universität Stuttgart, Prof. Dr.-Ing. Wolfram Ressel, die Bundesministerin für Bildung und Forschung, Anja Karliczek, und der Ministerialdirektor des Ministeriums für Wissenschaft, Forschung und Kunst Baden-Württemberg, Dr. Hans Reiter. Vertreter der Europäischen Union würdigten die Beiträge des HLRS zum Supercomputing auf europäischer Ebene. Den Abschluss der Zeremonie bildeten Kurzvorträge von hochrangigen Vertretern mehrerer internationaler Partner des Zentrums. Mit Blick auf die Zukunft stellte HLRS-Direktor Prof. Dr. Michael Resch fest, dass die Nachfrage nach größeren Supercomputern, das Aufkommen neuer Technologien – wie künstlicher Intelligenz und Quantencomputing – sowie die dringende Notwendigkeit, HPC umweltverträglicher zu machen, drei Schlüsselfaktoren sind, die die weitere Entwicklung des HLRS im kommenden Jahrzehnt vorantreiben werden. Weitere Informationen

26. Call for Large-Scale Projects: GCS vergibt 1,4 Milliarden Kernstunden

Mit dem 26. Call for Large-Scale Projects vergab das GCS rund 1,4 Milliarden Rechenkernstunden an anspruchsvolle nationale Forschungsprojekte, die eine Unterstützung durch High-Performance-Computing (HPC)-Technologie benötigen. Die insgesamt 15 Projekte, denen die GCS-Rechenzeitkommission Zugang zu den drei nationalen HPC-Zentren HLRS, JSC und GCS gewährte, kommen aus den Bereichen Ingenieurwissenschaften, Chemie und Hochenergiephysik. Einige der genehmigten Simulations-Großvorhaben werden dabei von Wissenschaftler:innen betreut, die ein GCS-Large-Scale-Projekt erstmalig federführend leiten: Prof. Andreas Pöppl von der Universität Leipzig erhielt 53 Millionen Kernstunden auf dem SuperMUC-NG-System des Leibniz-Rechenzentrums (LRZ) für sein Projekt "Ab-initio modeling of paramagnetic active sites in Zeolites and giant Metal-Organic Frameworks". Prof. Andrea Beck von der Universität Stuttgart und der Universität Magdeburg wurden 120 Millionen Kernstunden auf dem Hawk-System des HLRS für ihr Projekt "Large Eddy Simulation of Complex Boundary Layer Flows with Interactions" genehmigt, und das Projekt "Non-perturbative Heavy Quark Effective Theory" von Prof. Jochen Heitger (Universität Münster) wird mit 80 Millionen Kernstunden auf SuperMUC-NG unterstützt. Die komplette Liste der mit dem 26. GCS Large-Scale Call genehmigten Projekte ist auf der GCS-Website einsehbar.

JUWELS Booster ist schnellster KI-Supercomputer in Europa

Ein Forschungsteam von KI-Beraterinnen und -Beratern des JSC und des Karlsruher Instituts für Technologie (KIT) hat die Geschwindigkeit von KI-Anwendungen (Künstliche Intelligenz) sowohl auf dem JUWELS-Booster, als auch auf dem Hochleistungsrechner Karlsruhe (HoreKa) gemessen. Als Beitrag zum Wettbewerb „MLPerf Training HPC“ trainierten sie zwei Machine-Learning-Modelle, wobei sie die hohe Leistung der NVIDIA A100-GPUs und die Infiniband-Netzwerkverbindungen in beiden Maschinen ausnutzten. Auf JUWELS verwendeten sie bis zu 3072 GPUs und erreichten mit automatischer gemischter Präzision eine durchschnittliche Rechenleistung von etwa 100 PFlop/s. Dies waren die schnellsten und rechenintensivsten KI-Berechnungen, die jemals in Europa durchgeführt wurden.

Bei den Benchmark-Wettbewerben handelt es sich um rechenintensive Deep-Learning-Modelle. Das Modell Cosmoflow sagt kosmologische Parameter aus den Ergebnissen von kosmologischen Simulationen voraus; DeepCam identifiziert Regionen mit tropischen Stürmen in meteorologischen Daten. Das Training beider Modelle ist recht datenintensiv. Die Datensätze von 8 und 5 Terabyte wurden im Dateisystem des JSC in zwei großen HDF5-Dateien gespeichert. Der Trainingsalgorithmus las beide Dateien nacheinander. Der große Hauptspeicher vom JUWELS-Booster sorgt dafür, dass sie nur einmal gelesen werden müssen. Das Training wurde mit dem ML-Framework PyTorch durchgeführt, das eine automatisierte gemischte Präzision verwendet.

Die Beteiligung am Wettbewerb ist das Ergebnis einer Zusammenarbeit von Forschenden des Steinbuch Center for Supercomputing am KIT mit der Helmholtz-AI, dem KI-Kooperationsnetzwerk von Helmholtz-Zentren in ganz Deutschland. Deren KI-Beratung kann helfen, neue Anwendungen der Künstlichen Intelligenz in der Wissenschaft zu finden oder bestehende Anwendungen zu verbessern. Weitere Informationen

Quantencomputing stärkt Supercomputing

Um das Quantencomputing in den Forschungsalltag zu bringen und weiterzuentwickeln, beschafft das Leibniz-Rechenzentrum (LRZ) einen Quantencomputer des finnisch-deutschen Startups IQM. Das BMBF fördert diesen Kauf mit mehr als 40 Mio. Euro. Der Fokus für die Weiterentwicklung im Projekt „Quantencomputer-Erweiterung für Exascale-HPC (Q-Exa)“ liegt darauf, das High-Performance Computing (HPC) damit zu beschleunigen sowie Know-how für künftige Computer- und Informationstechnologien aufzubauen. Für Q-Exa wird erstmals in Deutschland ein 20-Qubit-Computer auf der Basis supraleitender Schaltkreise mit HPC-Ressourcen gekoppelt. Im Zusammenspiel von Supercomputing und Quantencomputing soll einerseits die neue Technologie für Wissenschaft und Wirtschaft alltagstauglich und kontrollierbar werden, andererseits kann das HPC deutlich höhere Leistungsstufen erreichen. Die Q-Exa-Strategie beruht auf Co-Design und Kooperation: Neben dem LRZ und IQM, sind die Firmen Atos, Anbieter von HPC- und Quantensystemen, sowie HQS Quantum Simulations beteiligt. Weitere Informationen

Das HLRS verbessert Kapazitäten für Urgent Computing: Projekt CIRCE

Globale Herausforderungen wie Pandemien und Naturkatastrophen verlangen schnelle Reaktionen vonseiten öffentlicher Behörden. In dem dreijährigen Projekt Computational Immediate Response Center for Emergencies (CIRCE) wird das Höchstleistungsrechenzentrum Stuttgart (HLRS) eine Studie durchführen, um den Bedarf und die möglichen Anwendungen von Simulationen, Hochleistungsdatenanalyse (HPDA) und künstlicher Intelligenz (KI) in Krisensituationen zu bewerten. Mithilfe von Sondierungsgesprächen mit potenziellen Partnern auf Bundes- und Landesebene wird das HLRS feststellen, welche Arten von Prognosetools den größten Nutzen bringen würden und welche Daten den Behörden zur Verfügung stehen, die als Grundlage für Prognosen dienen könnten. Zudem soll ermittelt werden, welche organisatorischen Verfahren erforderlich sind, um die sofortige Verfügbarkeit der HPC-Ressourcen des HLRS in Notsituationen zu gewährleisten. CIRCE wird vom Bundesministerium für Wissenschaft und Bildung (BMBF) und dem Ministerium für Wissenschaft, Forschung und Kunst des Landes Baden-Württemberg (MWK) kofinanziert. Weitere Informationen

The European PILOT: Pilotprojekt zur Nutzung unabhängiger lokaler und offener Technologien

Das JSC beteiligt sich an dem Projekt „The European PILOT: Pilot using Independent Local and Open Technologies“ (kurz: EUPILOT, oder manchmal auch Pilot-2 genannt). Im Rahmen von EUPILOT sollen die RISC-V-basierten Beschleuniger, die im EPI-Projekt (European Processor Initiative) entworfen wurden, zu einem vollständigen Ökosystem weiterentwickelt werden. Das Hauptziel des Projekts besteht darin, in einem Pilotsystem sowohl Open-Source-Software, als auch offene und proprietäre Hardware zu integrieren und deren Tauglichkeit für reale Anwendungen zu demonstrieren. Auf diese Weise soll das erste Beispiel für ein Pilot-HPC-Ökosystem entstehen, das vollständig in Europa entwickelt und hergestellt wird. Das Projekt verwendet einen Co-Design-Ansatz, um Bibliotheken und Anwendungen für die Plattform zu ermöglichen und die Leistung und Energieeffizienz zu verbessern.

Am EUPILOT, das vom Barcelona Supercomputing Center (BSC) koordiniert wird, nehmen 19 weitere akademische und industrielle Partner aus ganz Europa teil. Das Projekt wird von EuroHPC JU (Joint Undertaking) und den nationalen Einrichtungen der beteiligten Partner, einschließlich des deutschen Bundesministeriums für Bildung und Forschung (BMBF), kofinanziert. Es startete am 1. Dezember 2021 und hat eine Laufzeit von dreieinhalb Jahren mit einem Gesamtbudget von 30 Millionen Euro. Das Jülich Supercomputing Centre (JSC) wird im Rahmen des Projekts wichtige numerische Bibliotheken für das Pilotsystem portieren und Feedback zu den Architekturanforderungen als Teil des Co-Design-Prozesses geben. Die vom JSC im Rahmen dieses Projekts entwickelte Software wird für die nachhaltige Unterstützung der Plattform innerhalb der HPC-Gemeinschaft und darüber hinaus offen zugänglich gemacht. Weitere Informationen

JSC an der Entwicklung der EBRAINS HealthDataCloud beteiligt

EBRAINS, die vom europäischen Human Brain Project (HBP) entwickelte digitale Forschungsinfrastruktur, bietet eine Vielzahl von Ressourcen zur Unterstützung der Neurowissenschaften und der vom Gehirn inspirierten Forschung. Große datenwissenschaftliche Untersuchungen im Bereich der Neurowissenschaften und des Gesundheitswesens im Allgemeinen müssen sich einer wichtigen Herausforderung stellen: Die gesamte Forschung muss die Privatsphäre − und damit die Freiheit und die Rechte jedes und jeder Einzelnen − streng schützen und die Regeln der europäischen Datenschutzgrundverordnung (DSGVO) einhalten. Zu diesem Zweck wird EBRAINS sein Angebot für die wissenschaftliche Gemeinschaft um einen neuen Dienst für sensible medizinische Gehirndaten erweitern − die EBRAINS HealthDataCloud. Das Projekt wird von Europas größtem Universitätsklinikum, der Charité − Universitätsmedizin Berlin, koordiniert und mit 1 Million Euro gefördert.

In den nächsten zwei Jahren wird ein multinationales Team aus akademischen und industriellen Partnern im HBP, einschließlich des JSC, eine DSGVO-konforme, föderierte Forschungsdateninfrastruktur entwickeln. Diese soll neurowissenschaftliche Forschungskonsortien in ganz Europa in die Lage versetzen, mit sensiblen neurowissenschaftlichen Daten zu arbeiten, die von menschlichen Probanden stammen. Außerdem sollen Verfahren für die gemeinsame Nutzung der Daten und Ergebnisse festgelegt werden. Die EBRAINS HealthDataCloud wird auf dem DSGVO-konformen Virtual Research Environment (VRE) an der Charité basieren, das im EU-Projekt Virtual Brain Cloud entwickelt wurde, mit EBRAINS kompatibel ist und eine sichere und skalierbare Datenplattform für multinationale Forschungsteams bietet. Ein wichtiges Ziel des HealthDataCloud-Projekts ist die Föderation der Plattform und die Integration von HPC-Zentren wie dem JSC und anderen Standorten der Fenix-Infrastruktur als Satellitenknoten für rechenintensive Simulations- und Analyseaufgaben. Weitere Informationen

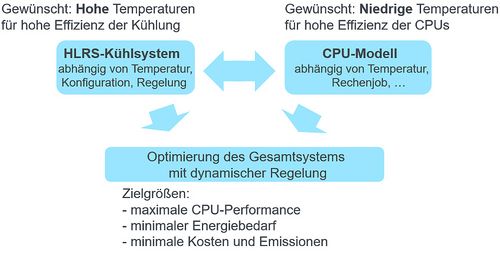

Energieeinsparung durch effizientere Kühlung: Projekt DEGREE

Neben den Rechensystemen verursachen deren Kühlsysteme den zweitgrößten Stromverbrauch in Rechenzentren. In dem neuen Projekt DEGREE, das vom Institut für Gebäudeenergetik, Thermotechnik und Energiespeicherung (IGTE) der Universität Stuttgart und dem Höchstleistungsrechenzentrum Stuttgart (HLRS) initiiert wurde, werden Forschende einen neuen Ansatz testen: Ziele sind es, die Energieeffizienz durch einen Kühlungsmix aus freier Kühlung und aktiver Kühlung sowie gleichzeitig das Verhältnis zwischen der Temperatur des Kühlkreislaufs und der bestmöglichen Leistung des Rechensystems zu optimieren. Dazu wird ein Leitfaden für Rechenzentrumsbetreiber entwickelt, um die dynamische Kühlungsregelung in ihren eigenen Einrichtungen zu testen und umzusetzen. Die Integration dieser Ansätze soll dazu beitragen, den Energieverbrauch und die CO2-Emissionen, die durch die Kühlung von Rechenzentren entstehen, zu senken. DEGREE wird mit einer Laufzeit von zwei Jahren von der Deutschen Bundesstiftung Umwelt (DBU) gefördert. Weitere Informationen

Neues NIC-Exzellenzprojekt am JSC

Zweimal im Jahr vergibt die NIC-Rechenzeitkommission den Titel „NIC-Exzellenzprojekt“ an herausragende Simulationsprojekte. Im Oktober 2021 verlieh die Kommission diese Auszeichnung Herrn Prof. Dr. Kurt Kremer vom Max-Planck-Institut für Polymerforschung in Mainz für seine Arbeiten zur nichtlinearen Viskoelastizität von Polymerschmelzen. In diesem Projekt werden die Mechanismen auf molekularer Ebene untersucht, die der Polymerrheologie bei starken Verformungen zugrunde liegen, was für die Grundlagenforschung und die industrielle Verarbeitung eine enorme Herausforderung darstellt. Prof. Kremer und seine Gruppe untersuchen diese Mechanismen, indem sie rheologische Experimente mit Molekulardynamiksimulationen nachbilden. Die Berechnungsexperimente gehen von äquilibrierten Proben geschmolzener Polymere aus, die viel länger sind als die Verhakungslänge − die durchschnittliche Anzahl von Monomeren zwischen zwei aufeinanderfolgenden topologischen Einschränkungen für die Kettenbewegung. Zu diesem Zweck wurde eine neue Strategie entwickelt, die auf der hierarchischen Darstellung der Polymerschmelzen beruht. Sie geht von Blob-basierten Ketten zur mikroskopischen Beschreibung aus und ist sowohl auf vereinfachte Polymermodelle wie auf reale Materialien, z. B. Polystyrol, anwendbar. Weitere Informationen

Projekt HPCQS − Vorreiter für föderiertes Quanten-Supercomputing in Europa

Mit dem Projekt "High-Performance Computer and Quantum Simulator hybrid" (HPCQS) tritt Europa in eine neue Ära des hybriden Quanten-Hochleistungsrechnens ein. Ziel ist es, zwei Quantensimulatoren mit jeweils über 100 Qubits eng mit zwei europäischen Supercomputern – dem HPC-System Joliot Curie von GENCI, das am CEA/TGCC betrieben wird, und dem modularen Supercomputer JUWELS am Jülich Supercomputing Centre (JSC) – zu verbinden. Das Infrastrukturprojekt ist Teil der Forschungs- und Innovationsaktion "Advanced pilots towards the European exascale Supercomputers" und wird gefördert durch das European High-Performance Computing Joint Undertaking (EuroHPC JU). HPCQS verfügt über ein Gesamtbudget von 12 Millionen Euro über 4 Jahre, das zu gleichen Teilen von EuroHPC JU und den teilnehmenden Mitgliedsstaaten finanziert wird. Das Projekt startete am 1. Dezember 2021.

Die nahtlose Integration von Quantenhardware in klassische Rechenressourcen zur Schaffung eines Hybridsystems ist ein wesentlicher Schritt nach vorn, um die Leistung von Quantencomputern für erste praktische Anwendungen zu nutzen. Am JSC ist HPCQS eine konsequente Fortsetzung der Bemühungen von JUNIQ, der JUelicher Nutzer-Infrastruktur für Quantencomputing, zur Etablierung enger hybrider Quanten-HPC-Simulationen. Prof. Dr. Kristel Michielsen vom JSC, einem der fünf beteiligten europäischen HPC-Zentren, koordiniert das Projekt.

HPCQS wird eine öffentliche Ausschreibung für innovative Lösungen (PPI) durchführen, um die beiden 100+-Qubit-Quantensimulatoren zu implementieren. Außerdem wird die Programmierplattform für den Quantensimulator entwickelt. Sie basiert auf zwei europäischen Softwareentwicklungen, der Quantum Learning Machine (QLM)™ von Atos und der ParaStation Modulo™ von ParTec. Zusammen ermöglichen diese Technologien erstmalig die tiefe, latenzarme Integration von Quantensimulatoren in klassische modulare HPC-Systeme. Darüber hinaus wird HPCQS an der Einführung eines vollständigen hybriden Software-Stacks arbeiten. Dazu gehören der Cloud-Zugang, die Ressourcenverwaltung für hybride Arbeitslasten, Tools und Bibliotheken, einschließlich Benchmarking und Zertifizierung sowie Leistungsanalyse. Die Einbeziehung der Nutzenden in die Mitgestaltung wird zu Prototypanwendungen für maschinelles Lernen und wissenschaftliche Simulationen führen. Weitere Informationen

Visualization Showcase: Supercomputing in Medizin und Pharmaforschung

Die Visualisierungsarbeit von Elisabeth Mayer, Mitarbeiterin im Zentrum für Virtuelle Realität und Visualisierung (V2C) des LRZ, schaffte es auf der internationalen Konferenz Supercomputing 2021 (SC21) unter die weltweit besten sechs wissenschaftlichen Visualisierungen im Wettbewerb Scientific Visualization Showcase. Gemeinsam mit ihrem LRZ-Kollegen Salvatore Cielo und einer Arbeitsgruppe um den britischen Mediziner und Informatiker Prof. Dr. Peter Coveney, gelang es den Spezialist:innen vom LRZ, den Blutfluss in den Venen und Arterien eines Unterarms zu modellieren und dreidimensional zu veranschaulichen. Die Visualisierung ist Teil des internationalen Forschungsprojekts CompBioMed, welches die Digitalisierung in der Medizin voranbringen soll. Mit Supercomputern wie dem HPC-System SuperMUC-NG soll anhand von Messwerten, Daten und Abbildungen ein lebender Mensch simuliert und visualisiert werden. Im Projekt „Virtual Human“ wird durch das Zusammenspiel smarter Mustererkennung und Supercomputing-Software zudem auch die Suche nach Wirkstoffen für Medikamente beschleunigt. Forschende von CompBioMed und Expert:innen des LRZ bauten innovative Screening-Prozesse auf und testeten diese am SuperMUC-NG in Garching. Weitere Informationen

JSC ist Partner im DFG-Projekt FMhub

Moderne Supercomputer eilen von einem Rechnerleistungsrekord zum nächsten. Diese sind derzeit nur durch eine stetig steigende Komplexität und Parallelität der Hardware zu erreichen. Daran muss Simulationssoftware immer wieder angepasst und erweitert werden. Um redundante Arbeiten zu vermeiden und Nachhaltigkeit zu erzielen, sind modulare Lösungen in der HPC-Softwareentwicklung ein wichtiger Ansatz. Mit unabhängigen und entkoppelten Software-Komponenten wird eine einfachere Wiederverwendbarkeit, Wartbarkeit und Portabilität erst möglich. Das neue, von der DFG geförderte Projekt FMhub zielt darauf ab, der wissenschaftlichen Gemeinschaft eine quelloffene, schnelle Multipolmethode (FMM) in Form einer flexiblen C++-Bibliothek namens FMSolvr zur Berechnung von Coulomb-Wechselwirkungen zur Verfügung zu stellen. Der Code wird zusammen mit Werkzeugen zu Versionskontrolle, Fehlermonitoring, Continuous Integration und Deployment sowie einer umfassenden Dokumentation zur Verfügung gestellt. Das Projekt startete im September und hat eine Laufzeit von drei Jahren. Projektpartner sind ein Team am Jülich Supercomputing Centre sowie Prof. Dr. Matthias Wernervon der Technischen Universität Chemnitz, Fakultät für Informatik.

24. Results & Review Workshop am HLRS und Golden Spike Awards 2021

Anfang Oktober kamen wissenschaftliche Nutzer:innen von HPC-Systemen am HLRS und am Steinbuch Centre for Supercomputing des Karlsruher Instituts für Technologie (KIT) virtuell zusammen, um auf dem jährlich stattfindenden Results & Review Workshop des HLRS ihre neuesten Forschungsergebnisse zu präsentieren und Erfahrungen bei der Optimierung der Leistung und Skalierbarkeit ihrer Codes zu diskutieren. Die Online-Veranstaltung umfasste 26 wissenschaftliche Vorträge und eine virtuelle Vorstellung mit 22 Postern, die sich mit computergestützter Forschung in einem breiten Spektrum wissenschaftlicher Disziplinen befassten, darunter u. A. Strömungsdynamik, reaktive Strömungen, Wetter- und Klimasimulation, Materialforschung, Informatik, Bioinformatik, Molekulardynamik, Physik und Strukturmechanik.

Zum Abschluss des Workshops zeichnete der Vizepräsident des HLRS-Lenkungsausschusses, Prof. Dr. Dietmar Kröner (Universität Freiburg), drei Projekte und ihre Vortragenden als Gewinner der Golden Spike Awards 2021 aus. Mit dieser Trophäe werden traditionell herausragende wissenschaftliche Anwendungen und der Einsatz von Hoch- und Höchstleistungsrechnern gewürdigt:

- Markus Scherer, Institut für Hydromechanik, Karlsruher Institut für Technologie. Projekt:

Secondary flow and longitudinal sediment patterns in turbulent channel flow over a bed of mobile particles in domains of small to intermediate size - Jakob Dürrwächter, Institut für Aerodynamik und Gasdynamik, Universität Stuttgart. Projekt: Uncertainty quantification in high order computational fluid dynamics

- Daniel Mohler, GSI Helmholtzzentrum für Schwerionenforschung GmbH, Darmstadt. Projekt: Hadronic contributions to the anomalous magnetic moment of the muon from lattice QCD

Wie in den vergangenen Jahren werden die Ergebnisse des Workshops in einem Band des Springer Verlags veröffentlicht. Weitere Informationen

Simulation and Data Lab Astrophysics and Astronomy am JSC: Künstliche Intelligenz schärft den Blick ins All

Auf der Suche nach fernen Galaxien, schnell rotierenden Neutronensternen und schwarzen Löchern sammeln Radioastronom:innen immer größere Datenmengen. Die nächste Generation von Radioteleskopen wird Daten in einer Größenordnung erzeugen, die mit dem gesamten heutigen Internetverkehr vergleichbar ist. Die Forschenden suchen daher nach völlig neuen Wegen, um diese Datenflut zu bewältigen. Künftig sollen maschinelles Lernen und künstliche Intelligenz helfen, aus der Datenflut die spannenden Signale des Universums herauszufiltern. Zu diesem Zweck haben sich acht Institutionen in Nordrhein-Westfalen unter der Leitung des Max-Planck-Instituts für Radioastronomie (MPIfR) zum "NRW-Cluster für datenintensive Radioastronomie: Big Bang to Big Data" (B3D) zusammengeschlossen: Das „Simulation and Data Lab Astrophysics and Astronomy“ am JSC ist Teil dieses Konsortiums. Das wesentliche Ziel der Allianz ist die Vernetzung von Wissen und die Koordination der Aktivitäten von Radioastronom:innen, Datenwissenschaftler:innen und Industriepartnern. Das JSC-Team wird vor allem daran arbeiten, die Simulationen und Beobachtungen enger zu verknüpfen und Algorithmen und Hardware-Konzepte für die zu erwartende Datenflut zu entwickeln. Das Land NRW fördert das B3D-Projekt mit bis zu drei Millionen Euro. Weitere Informationen

25 Jahre Archiv- und Backup-System am LRZ: 110 Petabyte gesicherter Daten

40 Millionen Sicherheitskopien aus rund 5000 Computeranlagen: Das LRZ in Garching speichert zurzeit rund 110 Petabyte an Daten aus Forschungsinstitutionen. Das Archiv- und Backupsystem (ABS) besteht heute aus 20 Servern, 5 Bandrobotern, 126 Bandlaufwerken und 2300 Festplatten und fasst rund 125 Petabyte Daten. Obwohl es in den letzten 25 Jahren stetig wuchs, blieb die Speichertechnik im Wesentlichen gleich: „Zwar hat sich die Hardware stark verändert“, sagt Werner Baur, der mit seinem Team das ABS betreut. „Der Dienst läuft trotzdem noch mit dem gleichen Konzept und der gleichen Software von IBM. Nur der Name wechselte öfter. Anfangs hieß die Software Adstar Distributed Storage Manager, ADSM, jetzt Spectrum Protect oder ISP.“ Zurzeit verfügt das ABS noch über 15 Petabyte freie Kapazität, 2022 erweitert das LRZ den Datenspeicher. Baur rechnet nicht mit großen technischen Veränderungen, Bänder bleiben Standard: „Die Unterschiede bei der Übertragungsgeschwindigkeit und bei den Kapazitäten werden zwar immer kleiner“, beobachtet der Speicher-Spezialist. „Für sehr große Datenmengen aber wird das Tape noch lange das wirtschaftlichste Speichermedium bleiben. Konzerne wie Amazon, Google, Microsoft bauen darauf – eine Garantie, dass die Technologie weiterentwickelt wird.“ Außerdem bleibe die Datensicherung unverzichtbarer Bestandteil des (Super)Computings: „Selbst wenn die Primärspeichermedien eine absolute, unbefristete Haltbarkeit garantierten“, meint Baur, „braucht man weiterhin Backups als Schutz gegen Cyberkriminalität oder menschliches Fehlverhalten.“ Weitere Informationen

Früher wurde das Wissen in Bücher geschrieben, heute lagert es in Bandlaufwerken und Tapes. © W. Baur/LRZ

CATALYST-Projekt: Digitalisierung des Werkstoffverhaltens von Blech

Die Fertigung von Tiefziehwerkzeugen, die Blech in eine PKW-Seitenwand umformen, setzt ingenieurwissenschaftliches Verständnis voraus, wie sich das Material unter physikalischen Belastungen während des Herstellungsprozesses verhält. Die Anwendung physischer Modelle zur Konstruktion von Umformwerkzeugen und die experimentelle Feinabstimmung der Parameter von Pressenlinien sind sehr kosten- und zeitaufwändig, sodass dafür HPC-Simulationen genutzt werden. Forschende des Instituts für Umformtechnik der Universität Stuttgart und des CATALYST-Projekts am HLRS evaluieren Möglichkeiten, um die Materialdaten für die Umformsimulation zugänglicher und akkurater zu machen. Unter Berücksichtigung des realistischen Materialverhaltens wird HPC eingesetzt, um bis zu 2 Mrd. Simulationen des Werkstoffverhaltens zu erstellen. Auf Basis dieser Daten können die Forschenden durch Deep-Learning-Methoden ein neuronales Netz darauf trainieren, das Verhalten diverser Metallarten zu evaluieren und zu definieren. Das daraus resultierende vereinfachte Modell könnte als Werkzeug in der Blechproduktion und -verarbeitung angewandt werden. Weitere Informationen

Das LRZ stellt sich in Video- und Audio-Präsentationen vor

Prof. Dr. Dieter Kranzlmüller, Leiter des Leibniz-Rechenzentrums (LRZ) in Garching, hatte sich im Rahmen der vom Deutschen Museum veranstalteten Vortragsreihe „Wissenschaft für jedermann“ der Herausforderung gestellt, das komplexe Thema Supercomputing anschaulich zu beleuchten. In seinem Vortrag „Rechnen mit Warp-Speed“, erläuterte er die Entwicklung, die Hintergründe und den Nutzen von High Performance Computing (HPC): Was ist eigentlich ein Supercomputer? Wie funktioniert er? Warum wirkt ein Supercomputer wie ein Turbo für die moderne Wissenschaft? An konkreten Beispielen aus der Astrophysik bis zur Zoologie erklärte Prof. Kranzlmüller, wie Forscher:innen den am LRZ betriebenen Höchstleistungsrechner SuperMUC-NG einsetzen und welche Erkenntnisse sie damit gewinnen. Der Mitschnitt seines Vortrags ist auf dem YouTube-Kanal des Deutschen Museums in voller Länge abrufbar.

Prof. Dr. Helmut Reiser, stellvertretender Leiter des Leibniz-Rechenzentrums, berichtet in einem Podcast von Cisco, Ingram Micro, über die Arbeit und die Dienste, die das LRZ nicht mehr nur in München und Bayern, sondern Forscher:innen auch deutschland- und europaweit zur Verfügung stellt. „Überall, wo in München Forschung und Lehre draufsteht, ist das Münchner Wissenschaftsnetz (MWN) und das LRZ dabei“, erklärt Prof. Reiser. Nebenbei erfahren Zuhörende, warum das LRZ seine Rechner mit warmem Wasser kühlt, wie man mehr als 311.000 Prozessoren beschafft und wie der nächste Supercomputer am LRZ, SuperMUC-NG Phase 2, aufgebaut werden wird.